不少人在接觸 AI 之後會有這個疑問:

「CUDA 是 AI 的標配,

那 Apple M 系列沒有 CUDA,為什麼也能跑 AI?」

甚至你可能實際遇過這種情況:

- MacBook 上能跑模型推論

- 一些模型速度還不慢

- 但完全沒看到 CUDA

這篇文章,我們從 設計哲學與系統架構 出發,一次把原因講清楚。

先說結論(一句話版)

Apple 沒有選擇 CUDA,是因為它打造了一套「從硬體到軟體完全整合」的 AI 執行路線。

不是不用 GPU、也不是不用加速,

而是 用「不同的方法」達到類似的目的。

CUDA 是什麼?先釐清對象

CUDA 是由 NVIDIA 推出的 GPU 平行運算平台,核心目標是:

- 把大量矩陣運算交給 GPU

- 適合 大型 AI 訓練

- 主力場景是 資料中心與工作站

📌 關鍵點:

CUDA 解的是「大規模訓練」問題

Apple 的 AI 目標,從一開始就不同

Apple 在設計 M 系列時,優先考量的是:

- 裝置端 AI(on-device AI)

- 即時推論(real-time inference)

- 低功耗、高能效

- 筆電、手機、平板一致體驗

👉 Apple 要解的不是「怎麼訓練超大模型」,

而是「怎麼在裝置上把 AI 用得順」

Apple M 系列的關鍵:不是只有 GPU

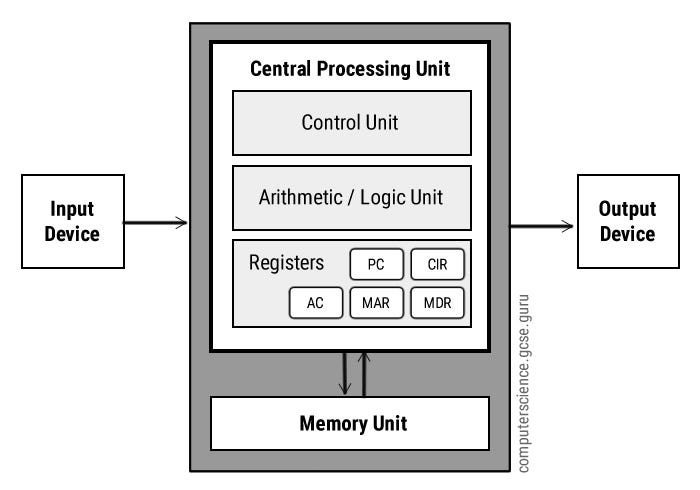

M 系列晶片不是「CPU + GPU」而已,而是:

- CPU

- GPU

- NPU(Neural Engine)

- 記憶體控制器

全部整合在一顆晶片中。

Neural Engine:專為 AI 推論而生

Neural Engine(NPU) 是 Apple 的秘密武器:

- 專門跑神經網路

- 功耗極低

- 對特定模型極快

📌 重點是:

它不是通用計算單元,

而是「為 AI 量身打造」

為什麼 Apple 不需要 CUDA?

因為 Apple 有三個替代方案,而且是一起用的。

① Metal:Apple 的 GPU 計算語言

Metal 是 Apple 的 GPU API:

- 角色 ≈ CUDA

- 但只支援 Apple 硬體

- 與 macOS / iOS 深度整合

👉 GPU 平行運算,Apple 用 Metal,不是 CUDA。

② Core ML:模型轉換與最佳化層

Core ML 負責:

- 把模型轉成 Apple 最適格式

- 自動決定跑在:

- CPU

- GPU

- Neural Engine

📌 開發者不需要自己管硬體細節。

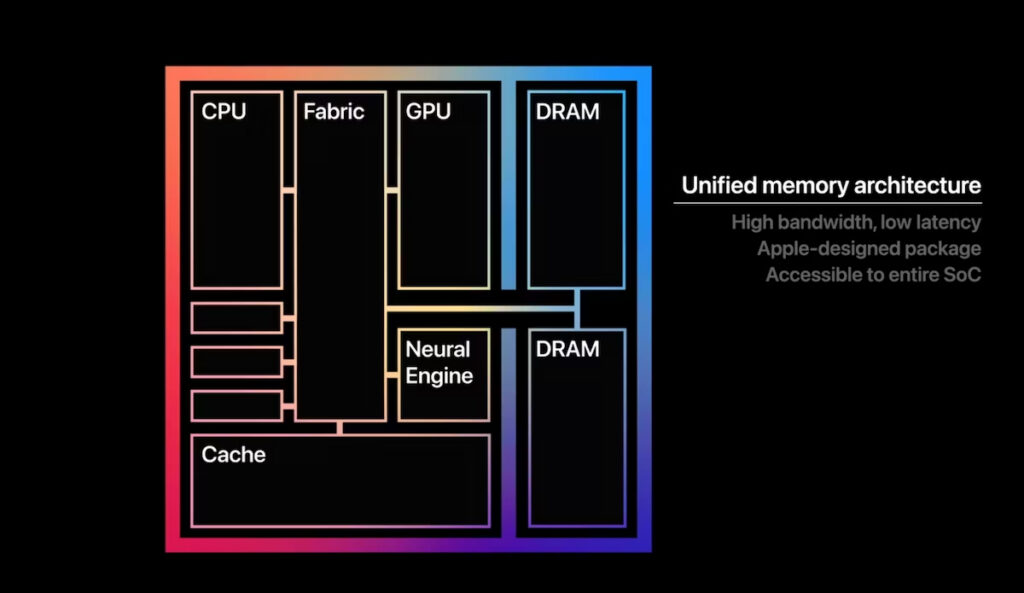

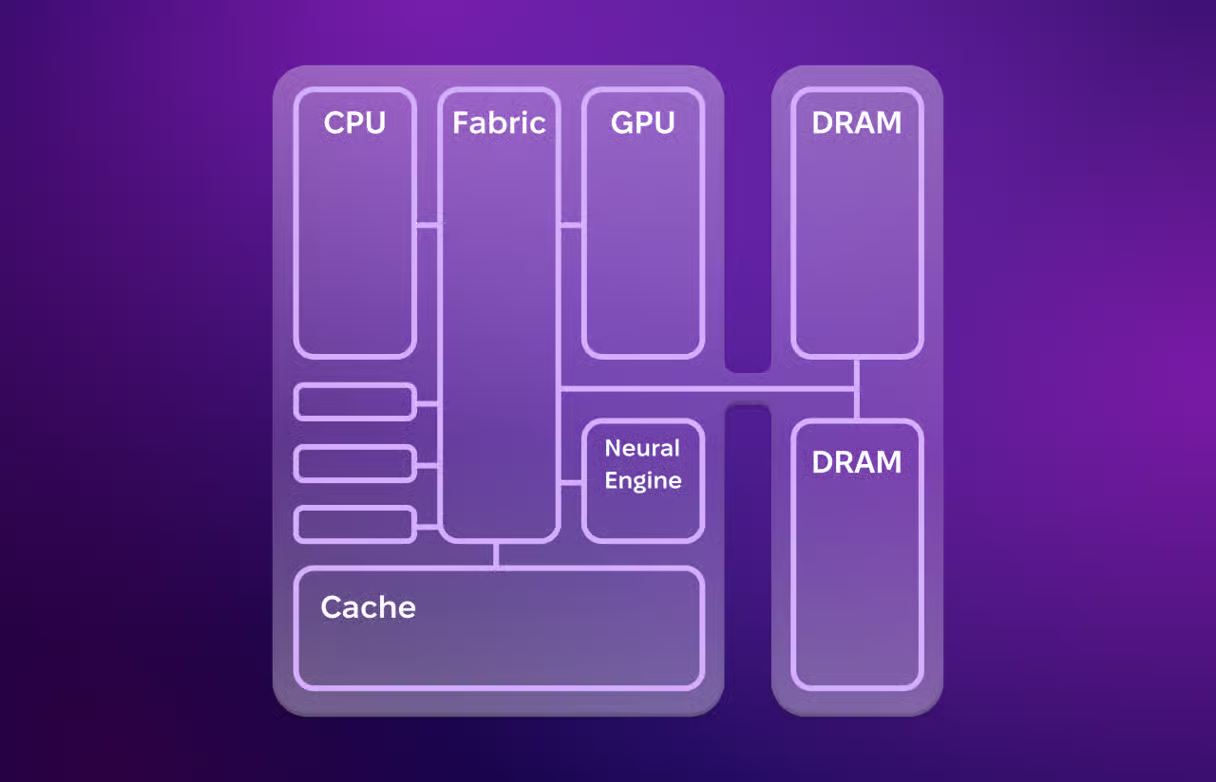

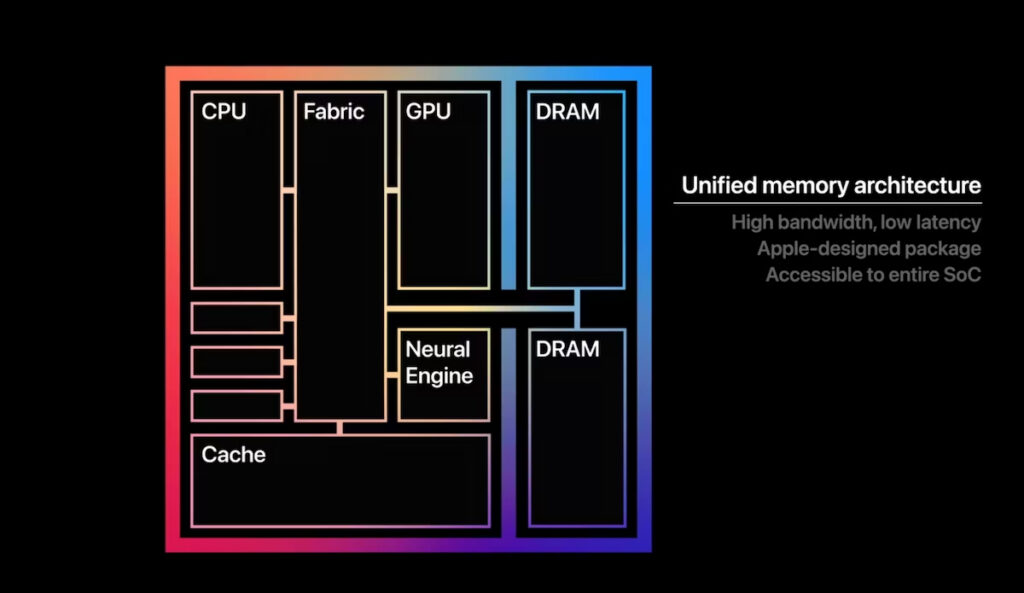

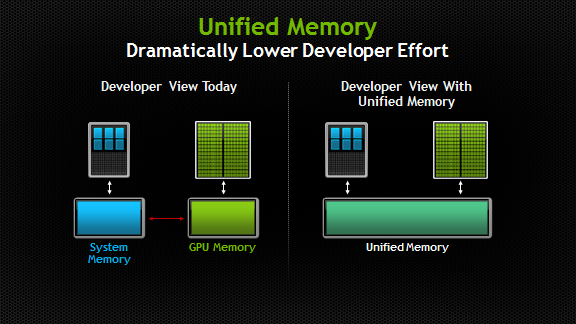

③ Unified Memory:一個大優勢

Apple 採用 Unified Memory Architecture:

- CPU / GPU / NPU 共用同一塊記憶體

- 不需要「搬資料」

- 延遲低、能耗低

👉 這對 推論(inference) 特別有利。

那 Apple 能不能訓練大型模型?

實話實說:

不適合,也不是目標

Apple M 系列適合:

- 模型推論

- 微調(fine-tuning)

- 邊緣 AI

- 個人 AI 助手

不適合:

- 上百億參數模型訓練

- 多 GPU 分散式訓練

- 資料中心級 AI 計算

👉 這正是 CUDA + NVIDIA GPU 的主場。

用一張表快速理解差異

| 項目 | Apple M 系列 | NVIDIA + CUDA |

|---|---|---|

| 主要目標 | 裝置端 AI | 大規模訓練 |

| 功耗 | 極低 | 高 |

| 記憶體 | Unified | VRAM 分離 |

| GPU API | Metal | CUDA |

| AI 加速 | Neural Engine | Tensor Cores |

| 適合場景 | 推論 / 個人使用 | 訓練 / 資料中心 |

所以,Apple 不用 CUDA 是「劣勢」嗎?

不是。

👉 這是 路線選擇,不是技術落後。

- NVIDIA:

訓練優先、規模優先 - Apple:

體驗優先、能效優先

總結(帶走重點)

Apple M 系列不用 CUDA,

是因為它用「整合式晶片 + Metal + Neural Engine」

解的是「裝置端 AI」這個不同問題。

最後一句話

CUDA 解的是「怎麼算得更多」,

Apple 解的是「怎麼在你手上算得更好」。