隨著本地 LLM(Large Language Model)越來越熱門,很多人開始問:

「我手上的 Mac(Apple M 系列),

到底適不適合跑本地 LLM?」

答案不是簡單的「可以」或「不可以」,

而是要看 你想怎麼用、跑多大、要多快。

這篇文章會從 硬體架構、記憶體、實際使用情境 三個角度,幫你做出清楚判斷。

先給結論(重點版)

Apple M 系列「適合」本地 LLM 推論與輕量應用,

但「不適合」大型模型訓練與高並發部署。

如果你把 Apple M 系列當成:

- 個人 AI 助手

- 開發 / 測試環境

- 輕量 RAG 或推論平台

👉 那它其實 很好用。

什麼是「本地 LLM」?先對齊定義

所謂本地 LLM,通常指:

- 模型在 本機執行

- 不依賴雲端 API

- 常見模型尺寸:

- 7B

- 8B

- 13B(量化後)

📌 重點不是「最大能跑多大」,

而是 「能不能順、穩、長時間跑」。

Apple M 系列的三個關鍵優勢

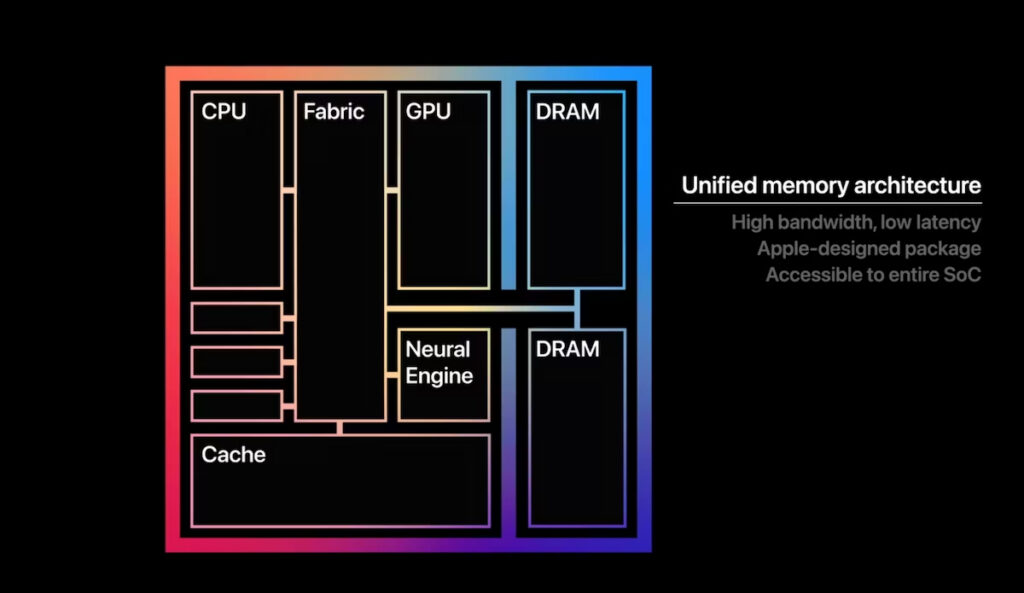

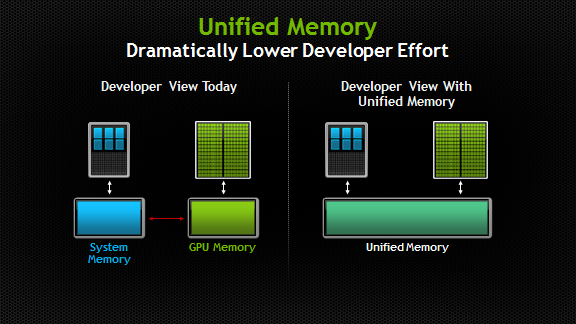

① Unified Memory(統一記憶體)= 本地 LLM 大加分

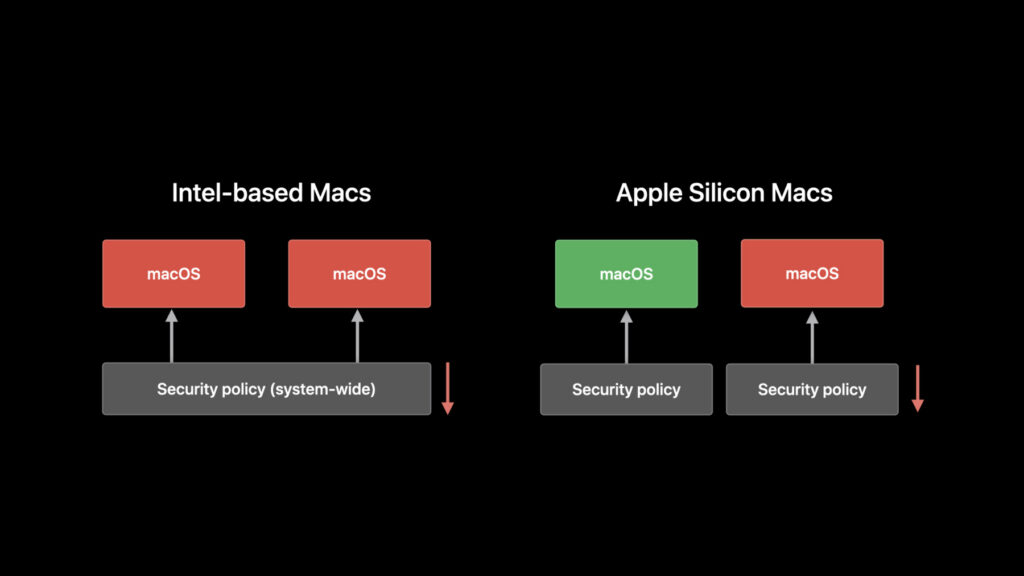

Apple M 系列採用 Unified Memory Architecture:

- CPU / GPU / Neural Engine 共用同一塊記憶體

- 不需要在 RAM ↔ VRAM 間搬資料

- 對 LLM 推論非常友善

👉 對本地 LLM 來說,

「記憶體能不能一次放下模型」比 GPU 核心數更重要。

② 能效比極高(筆電也能跑)

Apple M 系列的最大特色之一是:

- 功耗低

- 發熱小

- 可以長時間跑模型而不降頻

📌 實際體驗上:

- 一台 MacBook Pro

- 可以穩定跑本地 LLM 推論

- 風扇不狂轉、電池不秒掉

👉 這是 NVIDIA 桌機 GPU 做不到的體驗。

③ 生態已成熟(推論不是問題)

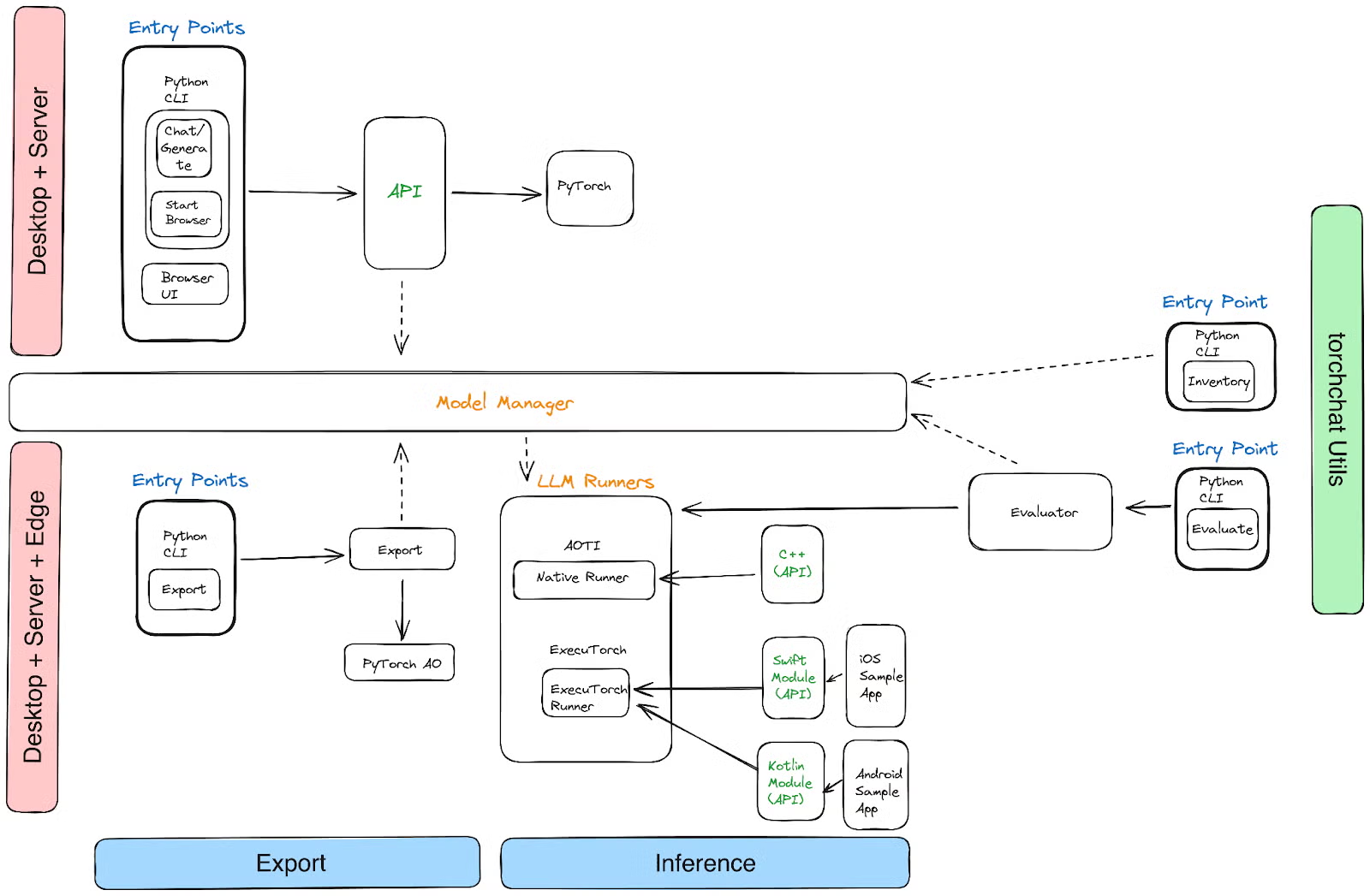

目前本地 LLM 在 macOS 上,已經有成熟工具鏈:

- llama.cpp(Metal backend)

- MLX(Apple 官方 ML framework)

- Ollama(macOS 友善)

👉 推論(inference)在 M 系列上不是障礙。

那限制在哪?(這才是關鍵)

❌ 1️⃣ GPU 算力不是為「大模型訓練」設計

Apple GPU:

- 強在能效

- 弱在純算力規模

👉 不適合:

- 上百億參數模型

- 長時間訓練

- 多卡並行

❌ 2️⃣ Neural Engine 對 LLM 支援有限

Neural Engine(NPU):

- 對影像、語音模型非常強

- 但對通用 Transformer LLM:

- 支援有限

- 大多仍跑在 GPU

👉 LLM 目前吃不到太多 NPU 紅利。

❌ 3️⃣ 記憶體「不可擴充」

Apple M 系列:

- 記憶體焊死

- 買的時候就定生死

📌 對 LLM 而言:

- 16GB:只適合小模型

- 32GB:7B / 8B 很舒服

- 64GB / 96GB:13B(量化)可行

👉 選錯記憶體容量,後悔成本極高。

Apple M 系列 vs NVIDIA GPU(本地 LLM 角度)

| 項目 | Apple M 系列 | NVIDIA GPU |

|---|---|---|

| 主要用途 | 推論 / 個人使用 | 訓練 / 大模型 |

| 記憶體 | Unified(大優勢) | VRAM 限制 |

| 能效 | 極高 | 低 |

| CUDA 支援 | ❌ | ✅ |

| LLM 訓練 | 不適合 | 非常適合 |

| 本地體驗 | 非常好 | 偏工程向 |

什麼情況「非常適合」Apple M 系列?

👉 如果你符合以下任一項:

- 想跑本地聊天型 LLM

- 想做 RAG / 文件問答

- 想要低噪音、低功耗

- AI 是「輔助工具」不是主戰場

✔️ Apple M 系列是 極佳選擇

什麼情況「不適合」?

👉 如果你想要:

- 訓練自己的大模型

- 多使用者高併發服務

- 追求極致 tokens/sec

- 長期擴充算力

❌ 那你需要的是 NVIDIA GPU + CUDA

一句話總結(請直接記這句)

Apple M 系列不是「算力怪獸」,

而是「本地 AI 體驗機」。

最後結論

Apple M 系列非常適合本地 LLM「推論與應用」,

但不適合把它當成 AI 訓練或伺服器主力。

如果你目標是:

- 個人 AI

- 本地知識庫

- 低功耗 AI 工具

👉 Apple M 系列會讓你用得很舒服。