當企業決定導入 本地 LLM + RAG,通常是因為這幾個原因:

- 資料不能上雲

- 使用頻率高,雲端成本失控

- 想要可控、可預期、可長期運作的 AI

- 希望把 AI 變成「日常工具」,而不是 Demo

但實務上你很快會發現:

本地 LLM + RAG 能不能成功,

關鍵不在模型,而在「架構與做法」。

這篇文章會整理 已被大量實戰驗證的最佳實務,幫你少走彎路。

先給結論(一句話版)

成功的本地 LLM + RAG,不是「把模型跑起來」,

而是「把推論、資料、記憶體與維運全部想清楚」。

一個重要前提:本地 LLM + RAG 是「推論系統」

請先牢記這件事:

本地 LLM + RAG = 長時間運作的推論服務

不是:

- 訓練系統

- Batch 任務

- 一次性程式

👉 你的設計思維,應該更像「企業服務系統」,而不是「研究實驗」。

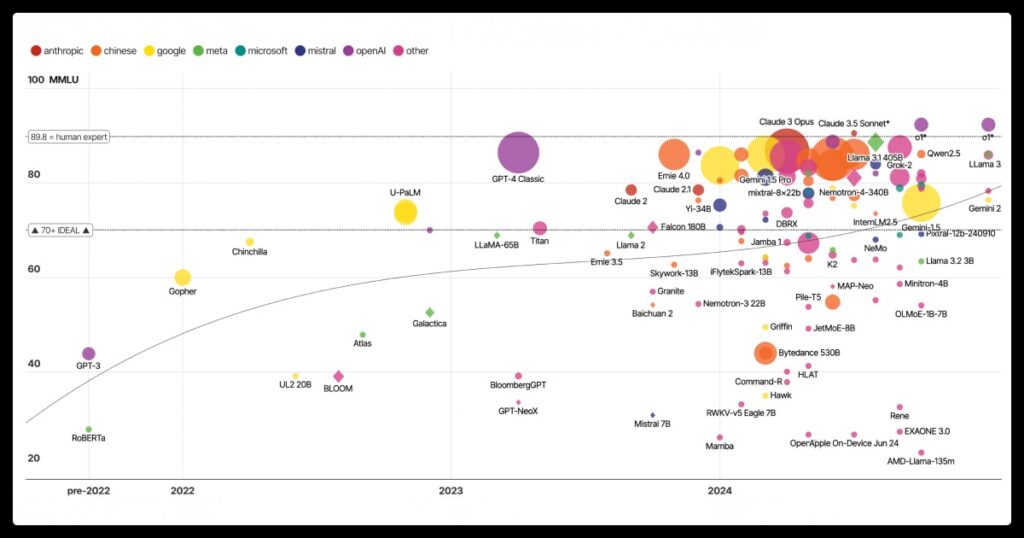

最佳實務一:模型選擇「穩定 > 最大」

實務建議

- 優先選擇 7B / 8B 等級模型

- 使用成熟、社群大的模型

- 不追求最大參數數量

📌 原因很簡單:

- RAG 會補知識

- 模型負責理解與表達

- 穩定與可控比極限能力重要

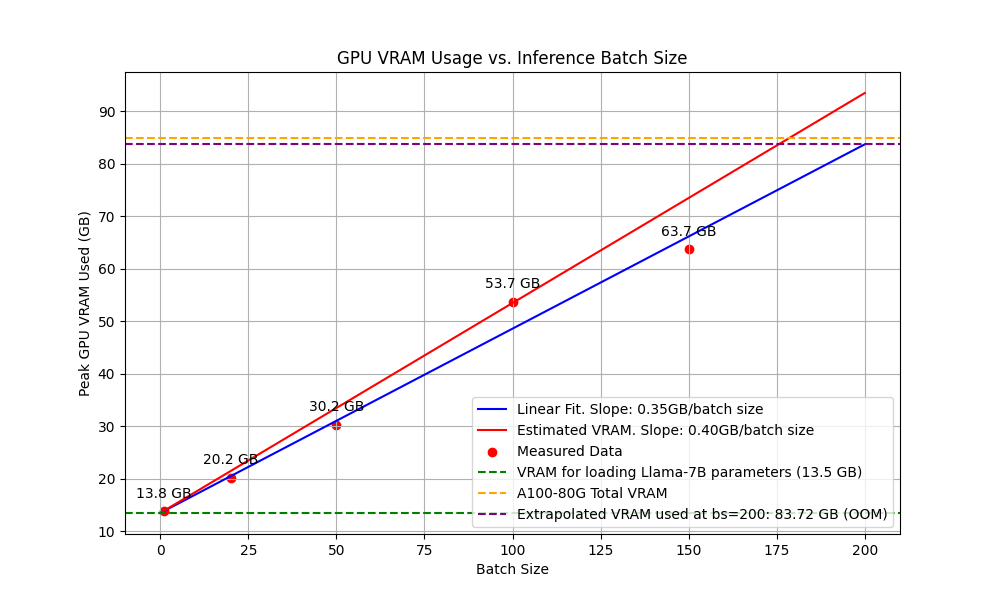

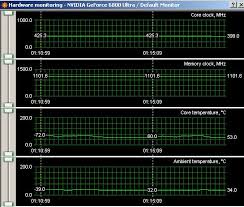

最佳實務二:VRAM 預算一定要留「餘裕」

切記這個原則

模型大小 ≠ 實際 VRAM 使用量

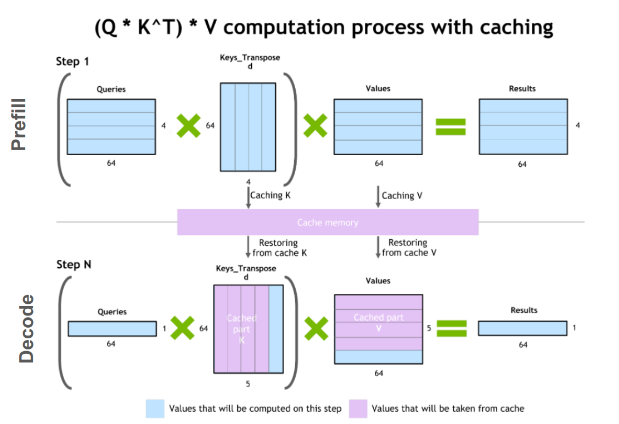

VRAM 還會被:

- KV Cache

- Context length

- Framework buffer

吃掉。

實務經驗

- 7B 模型 → 16GB 只是「剛好」

- 24GB → 才叫「舒服可用」

👉 沒有餘裕的 VRAM,系統一定不穩。

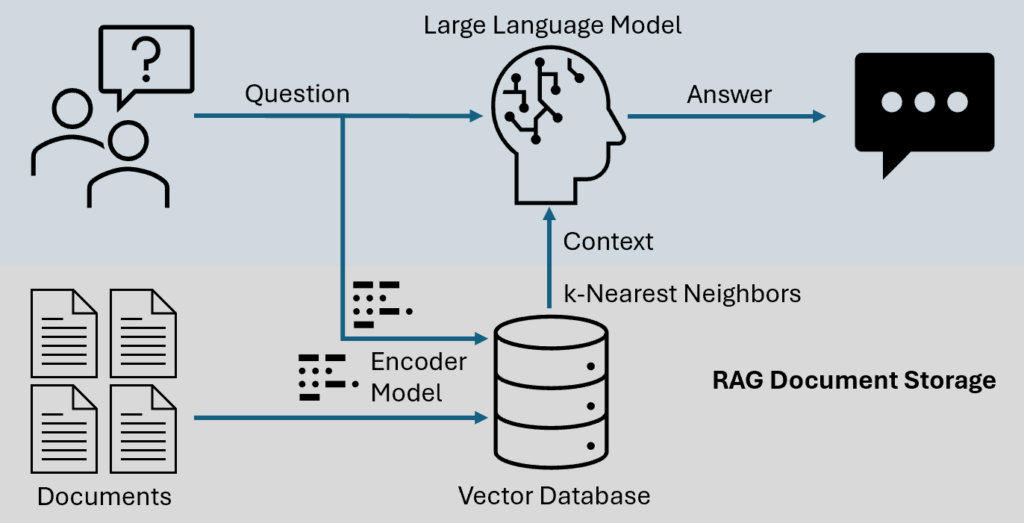

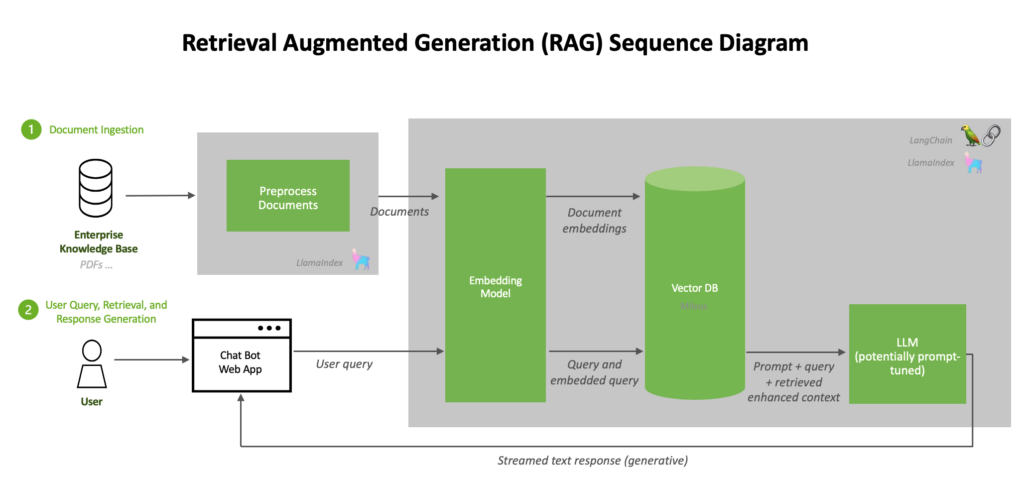

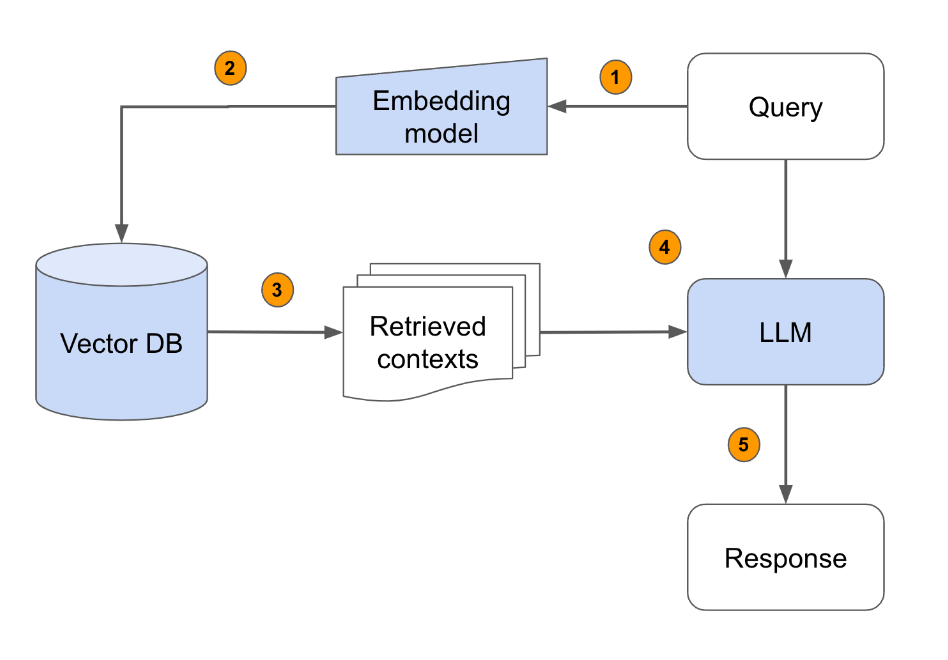

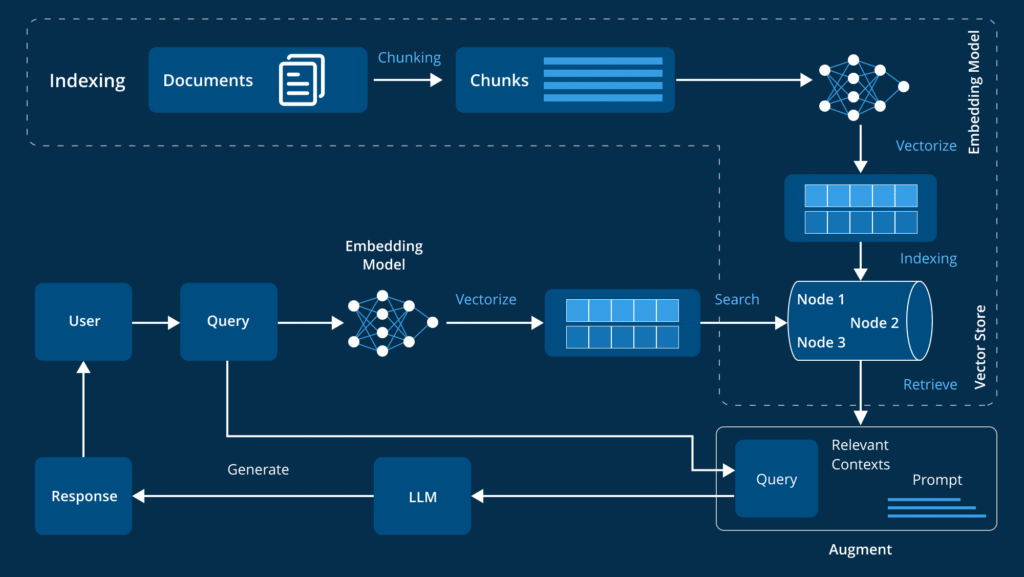

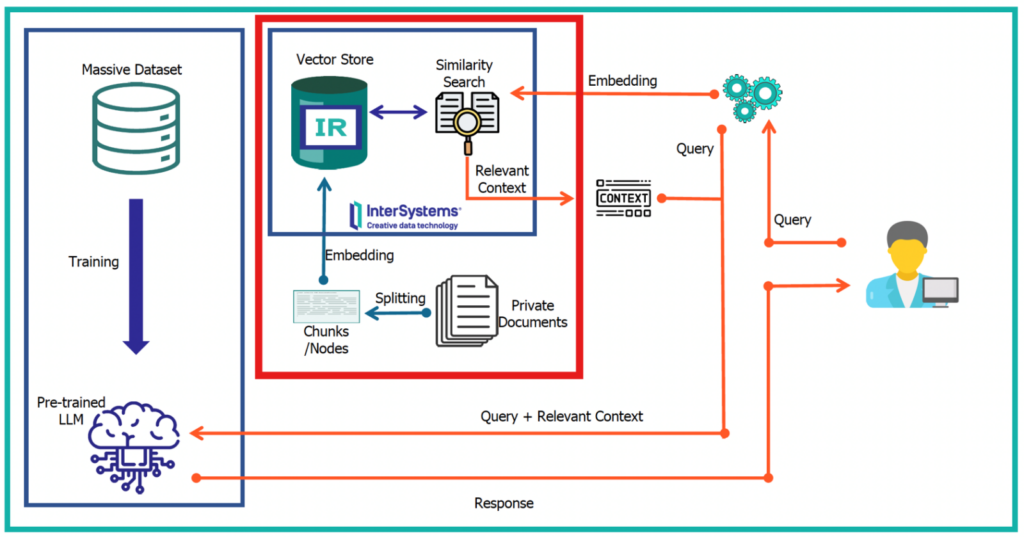

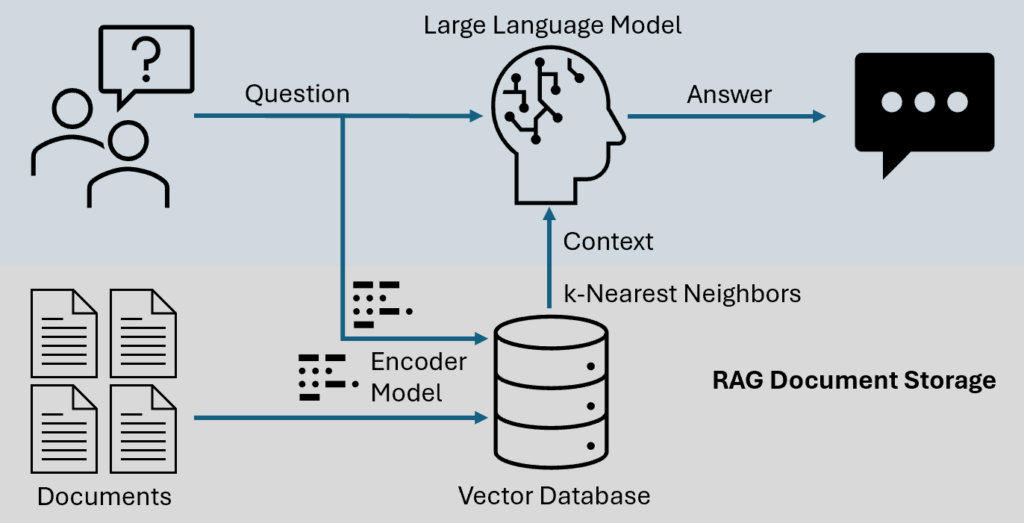

最佳實務三:RAG 一定要放在推論層

正確做法

- 文件向量化:離線

- 查詢、檢索、組 context:推論時

- 不改模型、不微調知識

📌 這讓你可以:

- 即時更新文件

- 即時下架資料

- 不用重訓模型

👉 RAG 的價值,就是避免重訓。

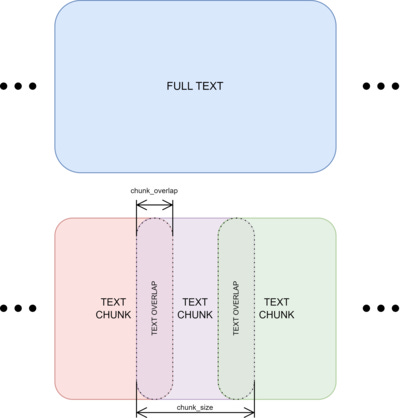

最佳實務四:文件切分(Chunking)比你想像重要

常見錯誤

❌ 文件整篇丟進向量庫

❌ Chunk 太大,搜尋不準

❌ Chunk 太小,語意斷裂

建議做法

- 300–800 tokens / chunk

- 適度 overlap(10–20%)

- 保留章節與標題資訊

👉 Chunking 決定 RAG 的上限。

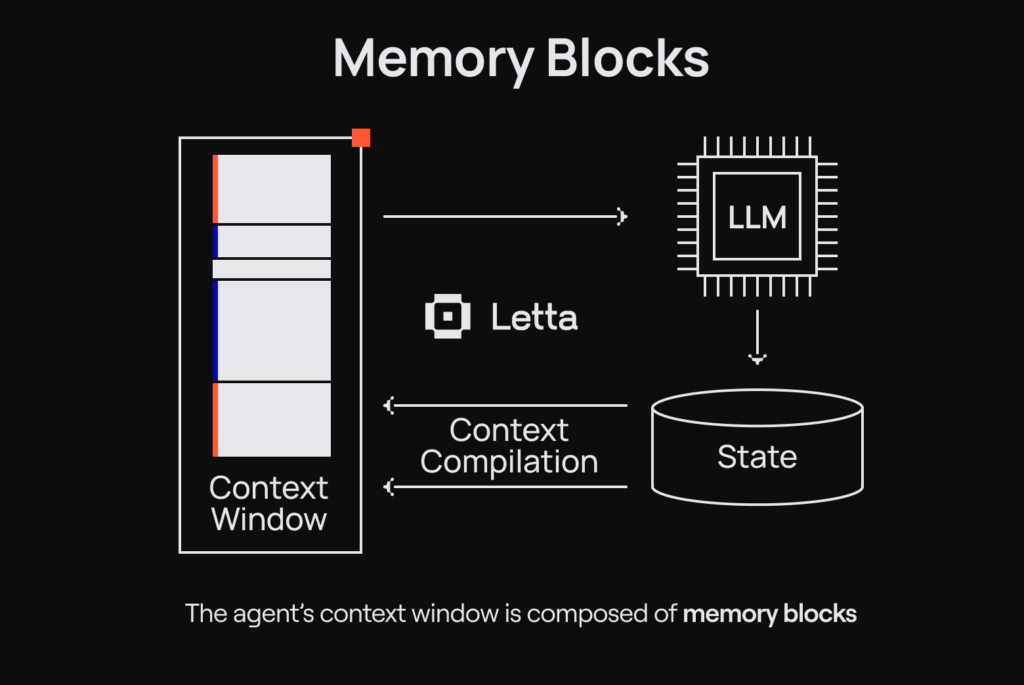

最佳實務五:Context 長度一定要「管起來」

原則

- 不要把所有搜尋結果全塞

- 設定 Top-K 上限

- 控制總 token 數

常見技巧

- 問題導向檢索

- 摘要後再塞

- 舊對話做 summarization

👉 Context 是最貴的資源。

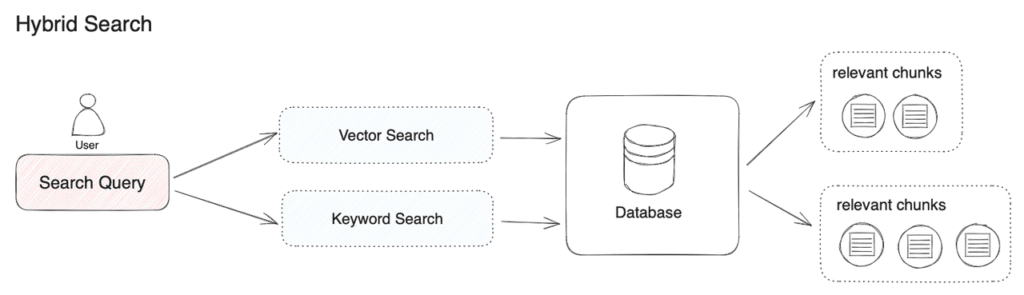

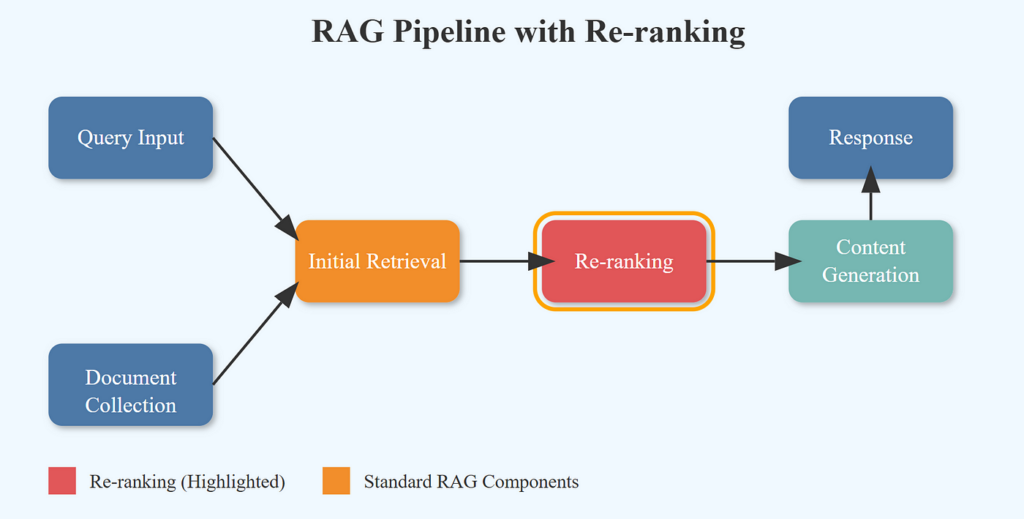

最佳實務六:RAG 不是只有向量搜尋

成熟的 RAG 通常會加入:

- 關鍵字搜尋(BM25)

- 向量搜尋

- Reranker(交叉編碼器)

📌 這能大幅降低:

- 撈錯資料

- 幻覺

最佳實務七:一定要有「推論層保護機制」

必備機制

- 最大併發限制

- Request queue

- OOM 保護

- Timeout

📌 本地 LLM 掛掉,

所有人都會一起掛。

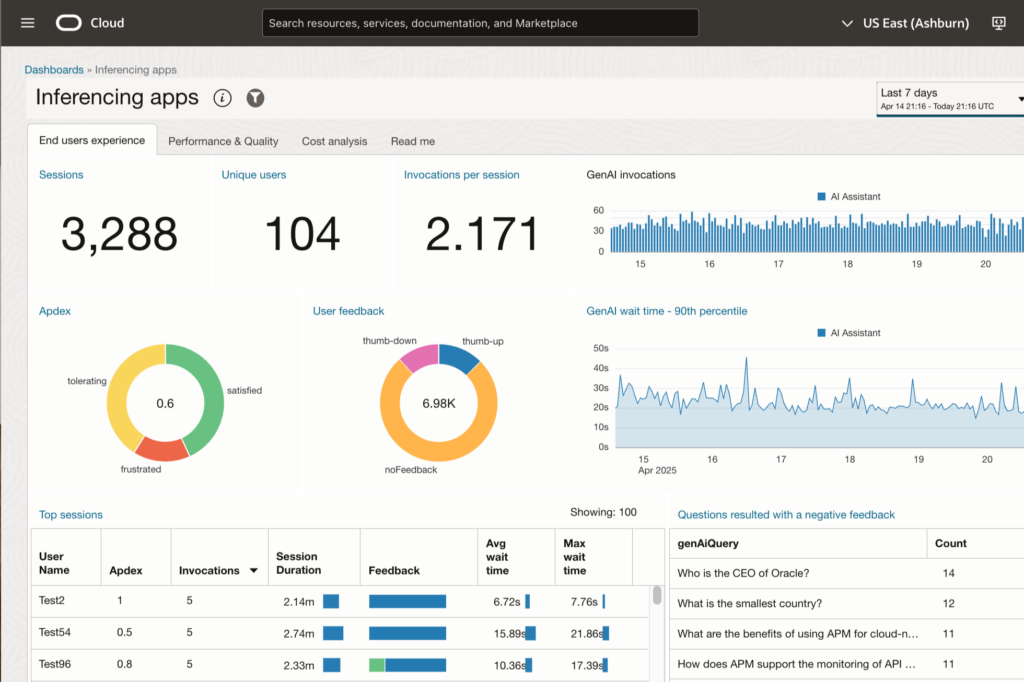

最佳實務八:監控比效能調校重要

至少要監控:

- VRAM 使用量

- Context token 數

- 回應延遲

- Error rate

👉 沒有監控的 AI,一定會在最忙的時候爆炸。

一個標準、可維運的本地 LLM + RAG 架構

推薦分層

- API / Gateway

- Inference Service(LLM)

- RAG Service

- Vector Database

- Document Pipeline

- Monitoring / Logging

👉 分層,是長期維運的關鍵。

一句話請直接記住

本地 LLM + RAG 的成功關鍵,

不是模型多大,而是「每一層都有邊界與控制」。

最後結論

本地 LLM + RAG 是一套「推論系統工程」,

不是單純的模型部署。

只要你:

- 管好 VRAM

- 管好 Context

- 把 RAG 放在推論層

- 有基本的監控與保護

👉 它會是一個 穩定、可控、長期省錢的 AI 平台。