很多團隊在導入 AI 時,會不自覺犯下一個錯誤:

「我們要跑 AI,就照訓練架構來設計吧。」

結果常見狀況是:

- GPU 規格買太高,卻用不滿

- VRAM 不夠,context 一拉就爆

- 速度不穩,延遲忽快忽慢

- 成本高,但使用體驗不佳

問題不在技術,而在 方向搞錯。

👉 推論為主的 AI,從一開始就該用「完全不同的架構思維」來設計。

先給結論(一句話版)

推論為主的 AI 架構,核心不是「算力最大化」,

而是「穩定、低延遲、記憶體友善、好維運」。

一個關鍵前提:你不是在「養模型」

在推論為主的場景中:

- 模型已經訓練完成

- 不需要反向傳播

- 不追求極致 FLOPS

👉 你在做的事情其實是:

「把模型,變成一個穩定可用的服務。」

推論架構設計的 5 大核心原則

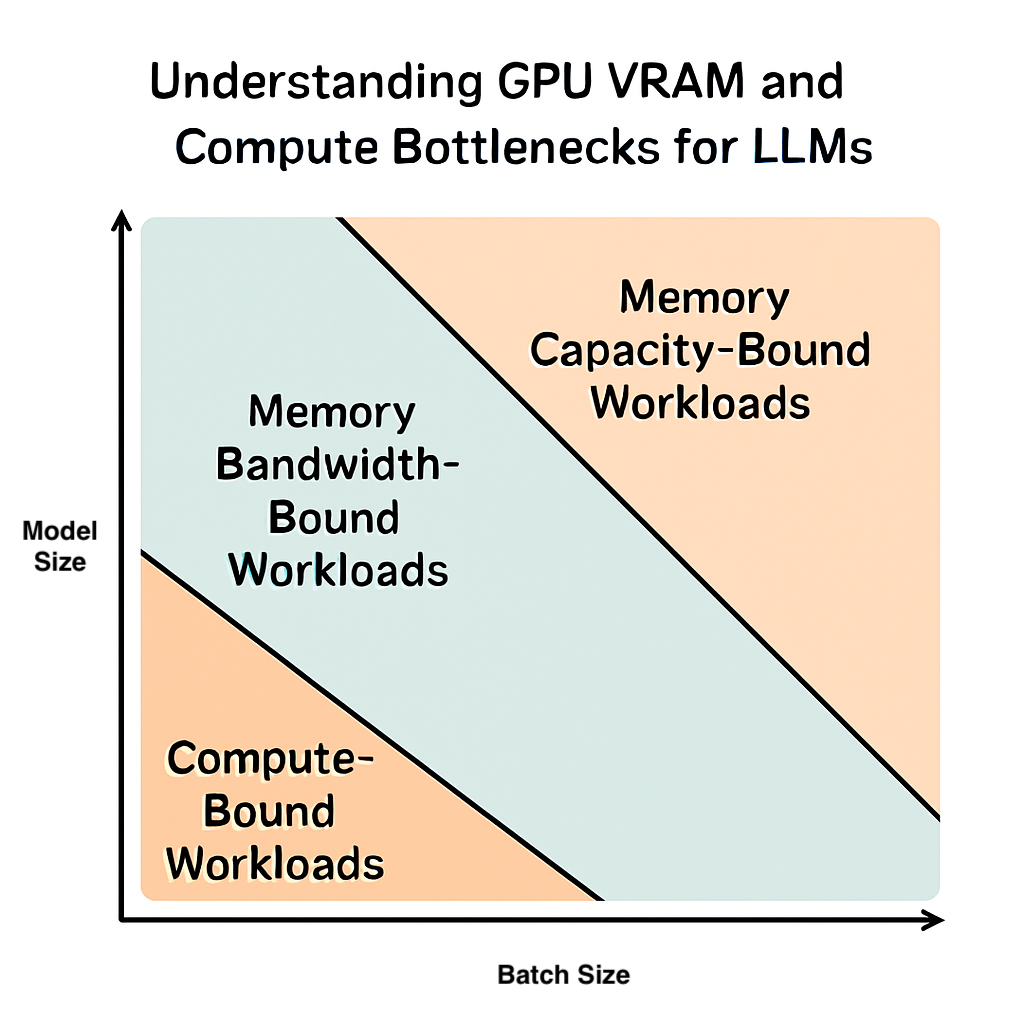

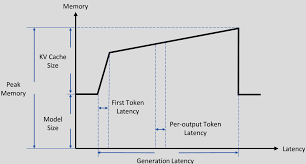

原則一:記憶體優先於算力

在推論場景中,第一個問題永遠是:

模型能不能完整放進記憶體?

設計重點

- VRAM / Unified Memory 是否足夠

- 模型大小(含 KV Cache、context)

- 預留 buffer 與 framework 空間

📌 算力不夠是「慢」,記憶體不夠是「不能用」。

原則二:延遲穩定性 > 峰值速度

推論不是 benchmark 比賽。

真實世界在意的是:

- 每次回應是否穩定

- P95 / P99 latency

- 使用者感知時間

📌 一個:

- 平均 50ms

- 但偶爾 500ms

的系統,體驗會比:

- 穩定 120ms

的系統差很多。

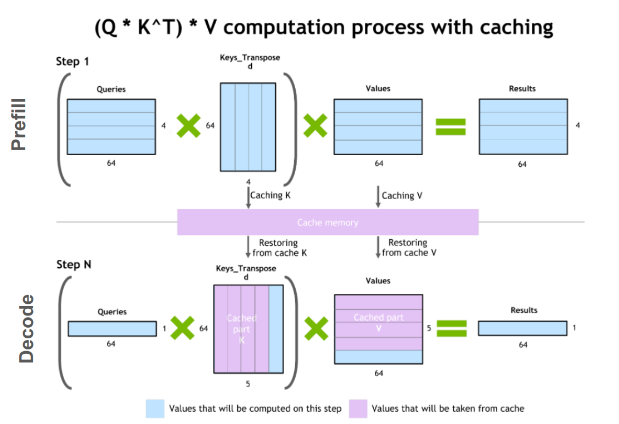

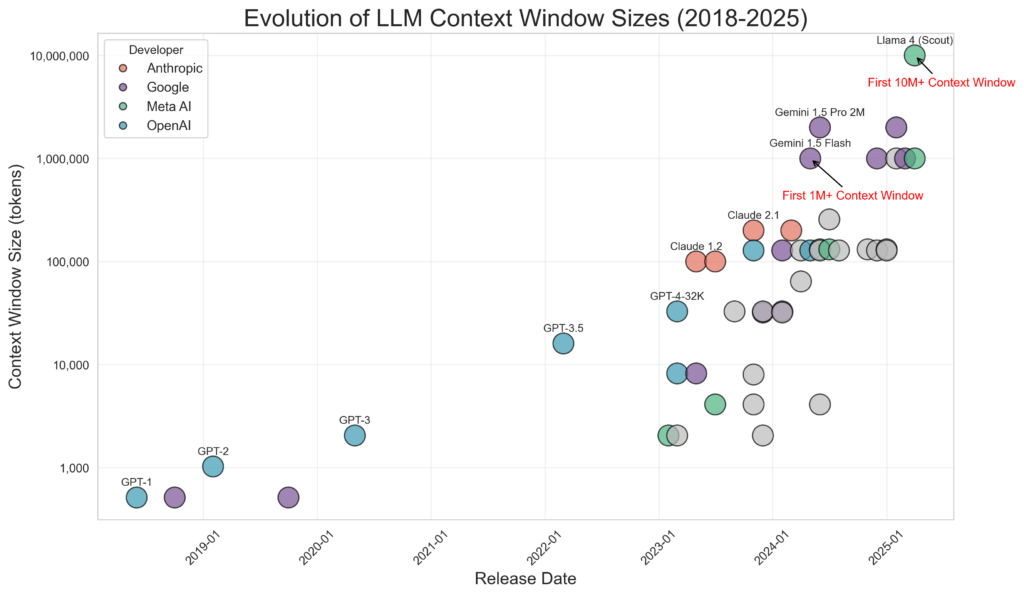

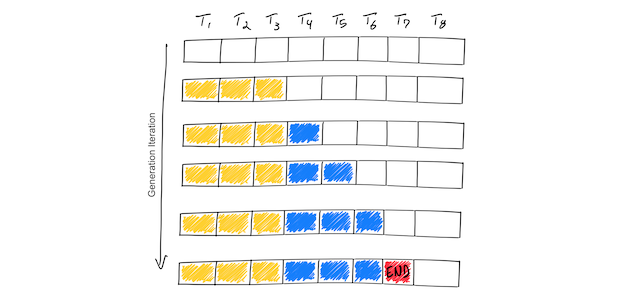

原則三:Context 與 KV Cache 要「被管理」

推論架構常被忽略的一件事是:

Context 不是免費的。

架構上要考慮:

- 最大 context length

- 是否截斷歷史

- 是否摘要(summarization)

- 是否分段(chunking)

👉 不管理 context,VRAM 一定被吃爆。

原則四:單一請求不等於可無限併發

推論常見誤解:

「模型能跑一次,就能同時跑很多人。」

實際上:

- 每個 request 都會吃 KV Cache

- VRAM 會線性疊加

- 併發 ≠ 免費

設計方式

- 設定最大併發數

- 使用 request queue

- 動態 batching(若適合)

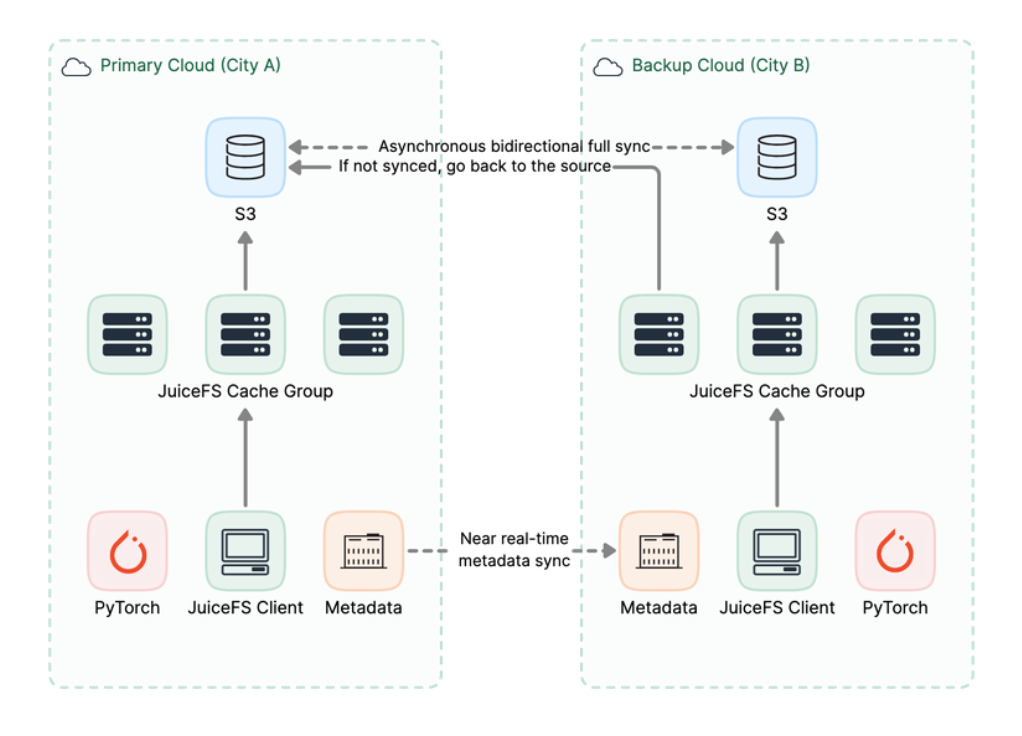

原則五:推論是「長期服務」,不是一次性任務

推論系統通常是:

- 24/7 運作

- 長時間穩定

- 要能觀測、回收、重啟

架構必備元素

- Health check

- Memory usage 監控

- OOM 保護

- Graceful restart

👉 穩定性與可維運性,比極致效能重要。

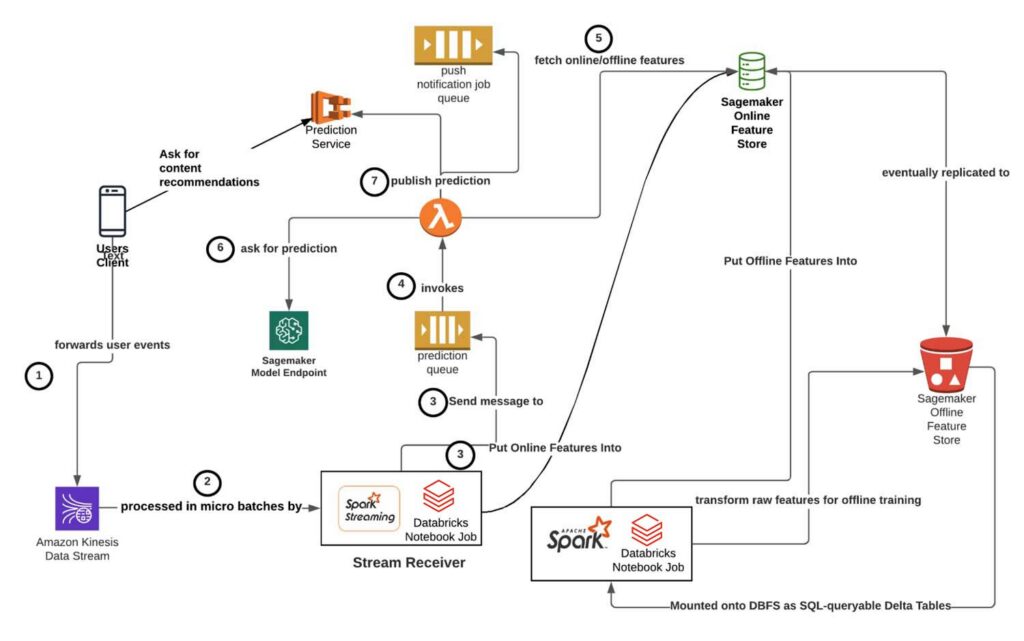

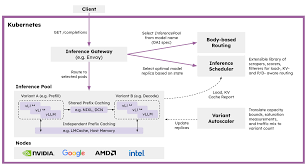

一個典型的「推論為主」AI 架構

常見組成如下:

- API Gateway

- 驗證

- 流量控制

- Request 限流

- Inference Service

- 常駐模型

- 控制 context

- 管理 KV cache

- Memory / VRAM Pool

- 模型常駐

- 避免反覆載入

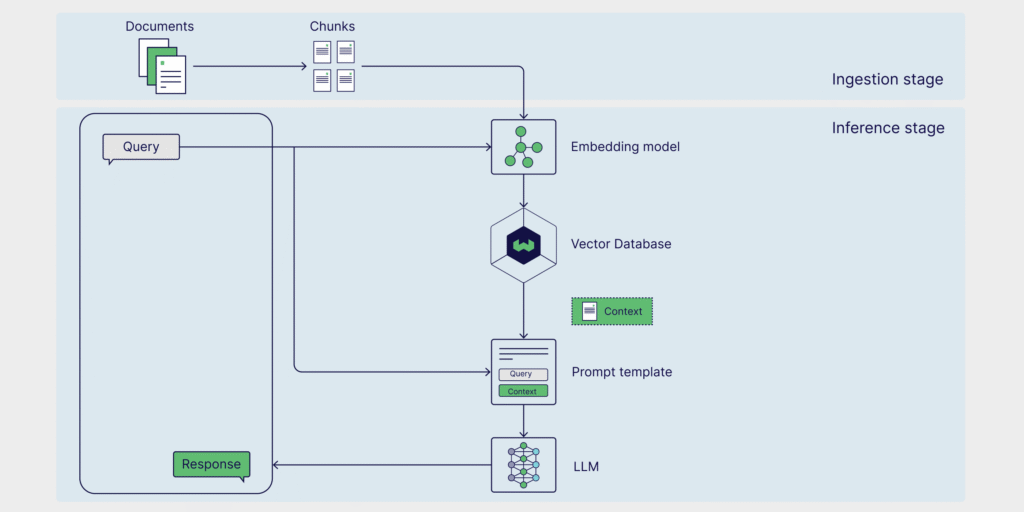

- Optional:RAG Layer

- 向量資料庫

- Context 組裝

- Monitoring

- Latency

- VRAM usage

- Error rate

推論為主 vs 訓練為主:設計差異總表

| 面向 | 推論為主 | 訓練為主 |

|---|---|---|

| 核心目標 | 穩定服務 | 模型學習 |

| 關鍵資源 | 記憶體 | 算力 |

| GPU 使用 | 中等 | 極高 |

| 延遲 | 極重要 | 不重要 |

| 系統型態 | 長期服務 | 批次任務 |

| 成本模型 | 持續營運 | 一次性 |

常見錯誤設計(請避開)

❌ 用訓練級 GPU 當推論主力

❌ Context 無限制成長

❌ 沒有併發控制

❌ 沒有 VRAM 監控

❌ 每個 request 都重新載入模型

一句話請直接記住

推論為主的 AI 架構,

本質上是一個「記憶體受限、延遲敏感的服務系統」。

最後結論

如果你的 AI 專案 80% 時間都在推論,

那你的架構就應該 80% 為推論而設計。

這代表:

- 不必追求最強 GPU

- 要追求最穩定的體驗

- 要能長期跑、不爆、不累