在 AI 專案中,最常見、也最昂貴的錯誤之一,就是這句話:

「我們要跑 AI,所以要買最強的 GPU。」

問題在於——

👉 你到底是要「訓練(Training)」還是「推論(Inference)」?

這兩件事,看起來都在「跑 AI」,

但對硬體的需求,卻是完全不同的世界。

先給結論(一句話版)

AI 硬體選擇的真正分水嶺,不是模型大小,而是「你在訓練,還是在推論」。

一旦分清楚這件事,

你就能省下大量不必要的硬體成本。

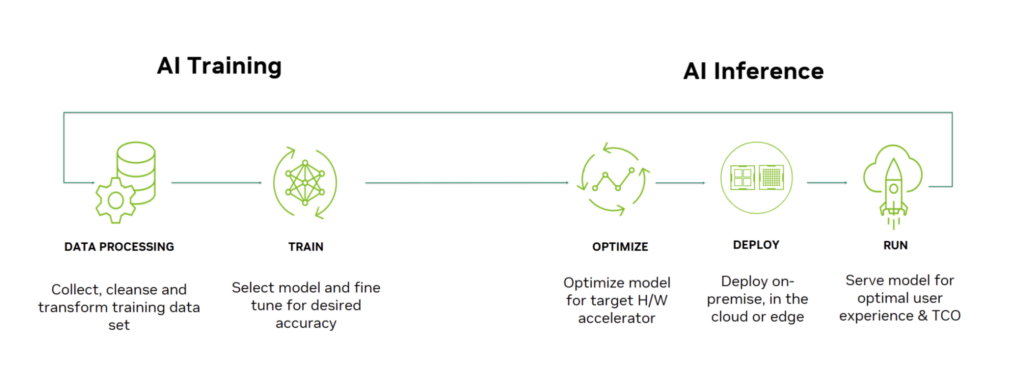

先把兩件事說清楚:什麼是訓練?什麼是推論?

🧠 訓練(Training)

- 目的:讓模型學會

- 行為:

- Forward(前向計算)

- Backward(反向傳播)

- 更新權重

- 特性:

- 計算量極大

- 吃 GPU 算力

- 跑一次要很久

💬 推論(Inference)

- 目的:使用已訓練好的模型

- 行為:

- 只有 Forward

- 不更新權重

- 特性:

- 計算較單純

- 吃記憶體與延遲

- 需要穩定、即時

👉 目標不同,一切需求就不同。

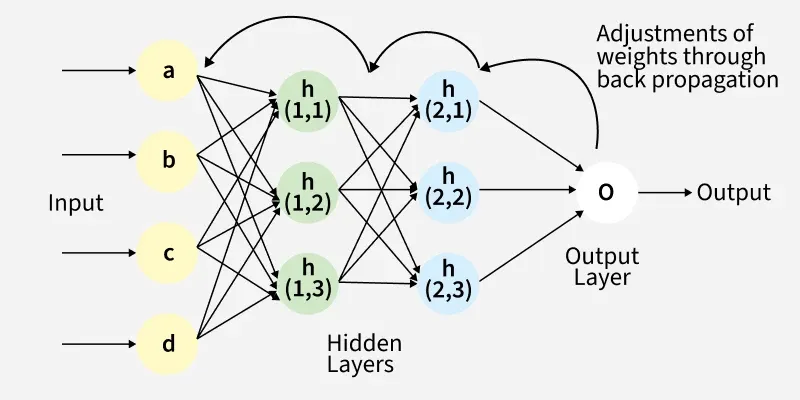

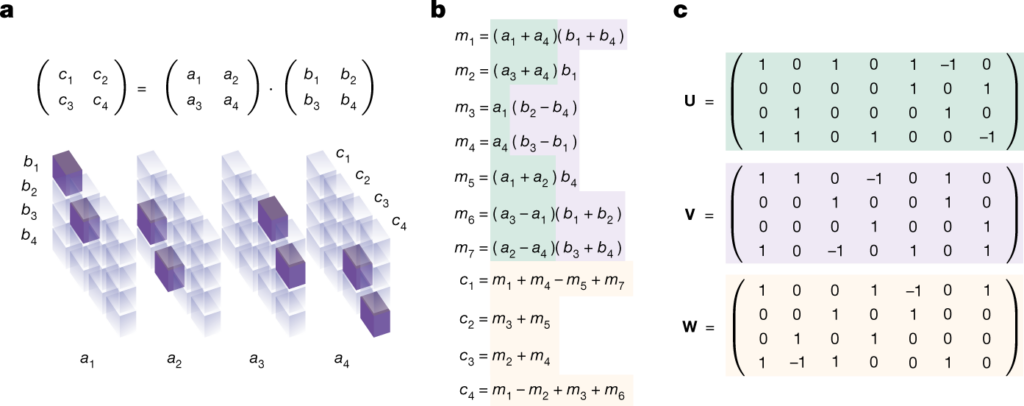

為什麼訓練是「算力導向」?

訓練的本質是:

- 大量矩陣 × 矩陣

- 重複數百萬~數十億次

- 可長時間全速運轉

因此,訓練硬體重視的是:

- GPU 核心數

- Tensor / Matrix 單元

- 多卡擴充能力

- 高功耗、高散熱

📌 訓練場景:硬體越猛,時間越短。

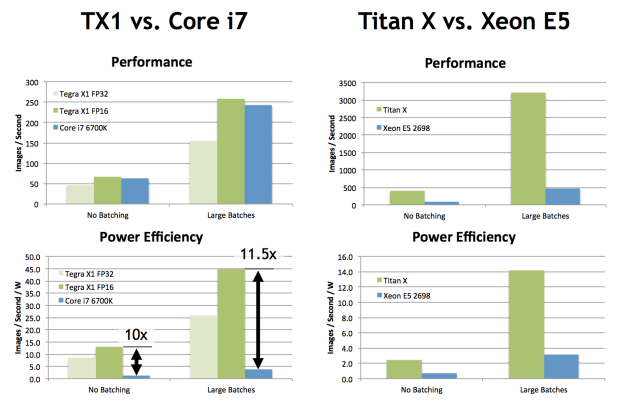

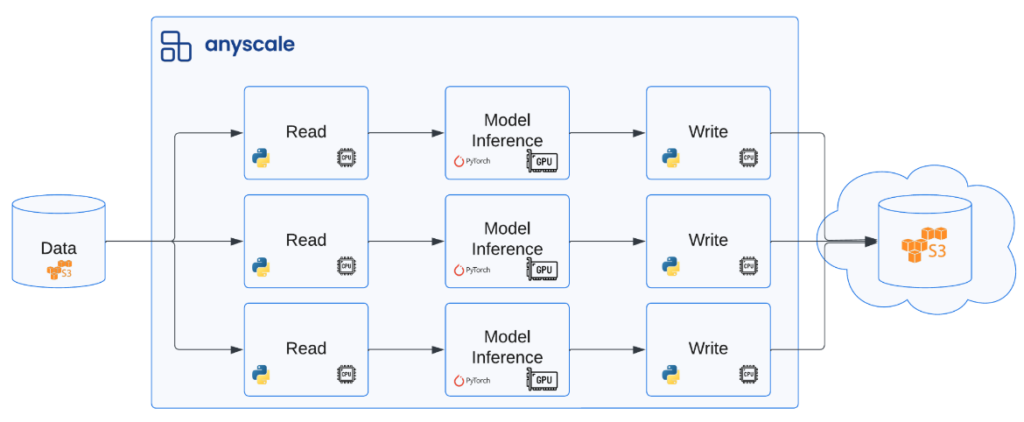

為什麼推論是「記憶體與效率導向」?

推論的本質則是:

- 一次產生一個 token

- 高度依賴歷史內容(KV Cache)

- 對延遲極度敏感

- 需要長時間穩定運行

因此,推論硬體重視的是:

- 記憶體容量(VRAM / Unified Memory)

- 延遲穩定性

- 能效比

- 部署與維運成本

📌 推論場景:夠用、穩定,比極速更重要。

一張表看懂真正的分水嶺

| 項目 | 訓練(Training) | 推論(Inference) |

|---|---|---|

| 核心目標 | 學會模型 | 使用模型 |

| 計算型態 | Forward + Backward | Forward only |

| GPU 算力需求 | 極高 | 中等 |

| 記憶體需求 | 高 | 非常關鍵 |

| 延遲要求 | 不敏感 | 極度敏感 |

| 可替代性 | 幾乎只能 GPU | CPU / GPU / NPU |

| 成本結構 | 一次性高投入 | 長期營運成本 |

為什麼很多人會選錯 AI 硬體?

因為 把訓練與推論混在一起想。

常見錯誤包括:

- 用「訓練級 GPU」跑個人或部門推論(浪費)

- 用「推論級設備」想訓練大模型(跑不動)

- 只看 FLOPS,不看記憶體與延遲

- 忽略實際使用者數與服務模式

你該怎麼選?一個實用判斷流程

請先問自己三個問題:

- 我要自己訓練模型嗎?

- 是 → 往訓練型硬體想

- 否 → 直接跳過訓練需求

- 是單人 / 小團隊使用,還是多人服務?

- 單人 → 本地推論、記憶體優先

- 多人 → 併發、穩定度優先

- 我在意的是速度,還是體驗與成本?

- 速度極限 → GPU 核心

- 體驗穩定 → 記憶體與能效

一句話請直接記住(非常重要)

訓練是在「養模型」,

推論是在「用模型」。

養模型要的是力氣,

用模型要的是空間、效率與穩定。

最後結論

AI 硬體選擇的真正分水嶺,

不是模型大小,也不是品牌,

而是你到底在做「訓練」還是「推論」。

一旦你搞清楚這一點:

- 硬體不再亂買

- 成本不再失控

- 架構設計會清楚很多