很多人在評估 AI 時,心中都會冒出這個問題:

「我是不是該自己架一套本地 LLM?

還是直接用雲端比較省?」

答案其實不是立刻買硬體、也不是立刻刷 API,

而是要先想清楚一件事:

👉 你付錢的方式,到底是「一次性」,還是「每天都在燒」?

先給結論(一句話版)

本地 LLM 會在「使用頻率高、長時間運作、資料內部化」的情況下,

明顯比雲端省錢。

反過來,如果你只是:

- 偶爾用

- 測試用

- 不確定會不會常用

👉 雲端幾乎一定比較便宜。

先拆解兩種成本模型(非常重要)

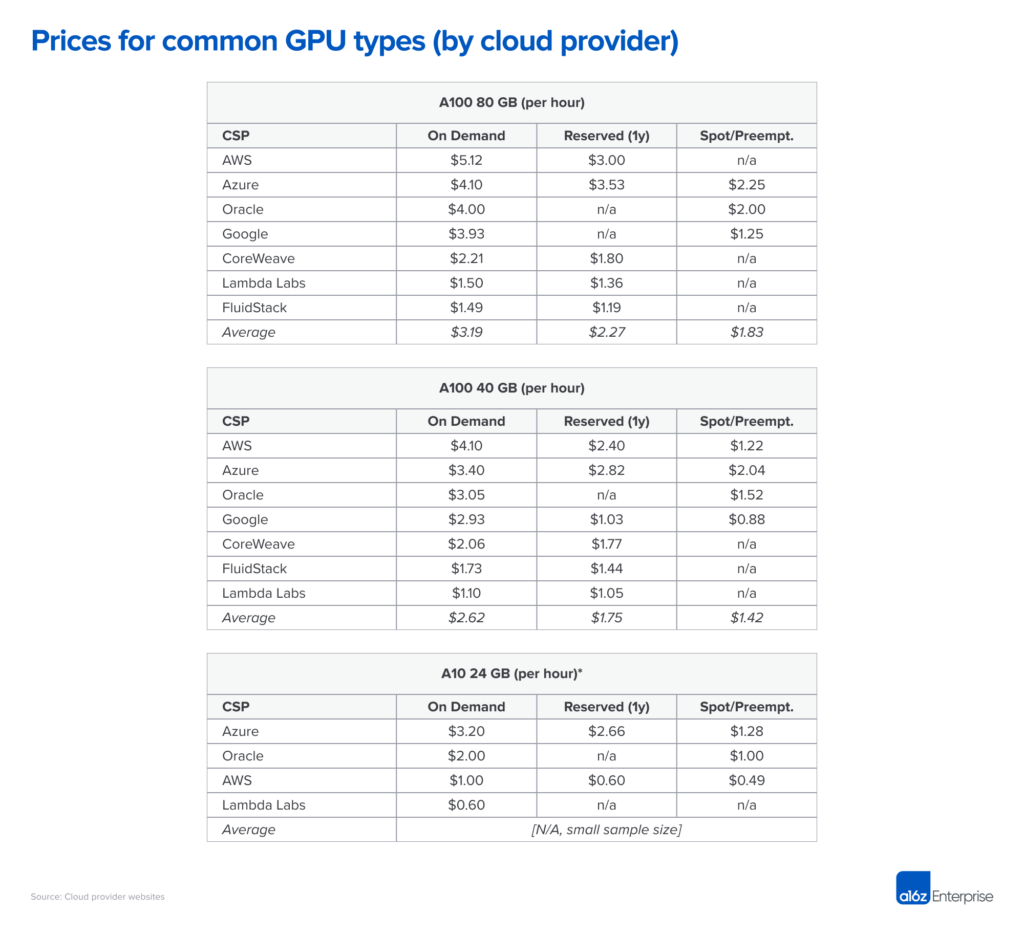

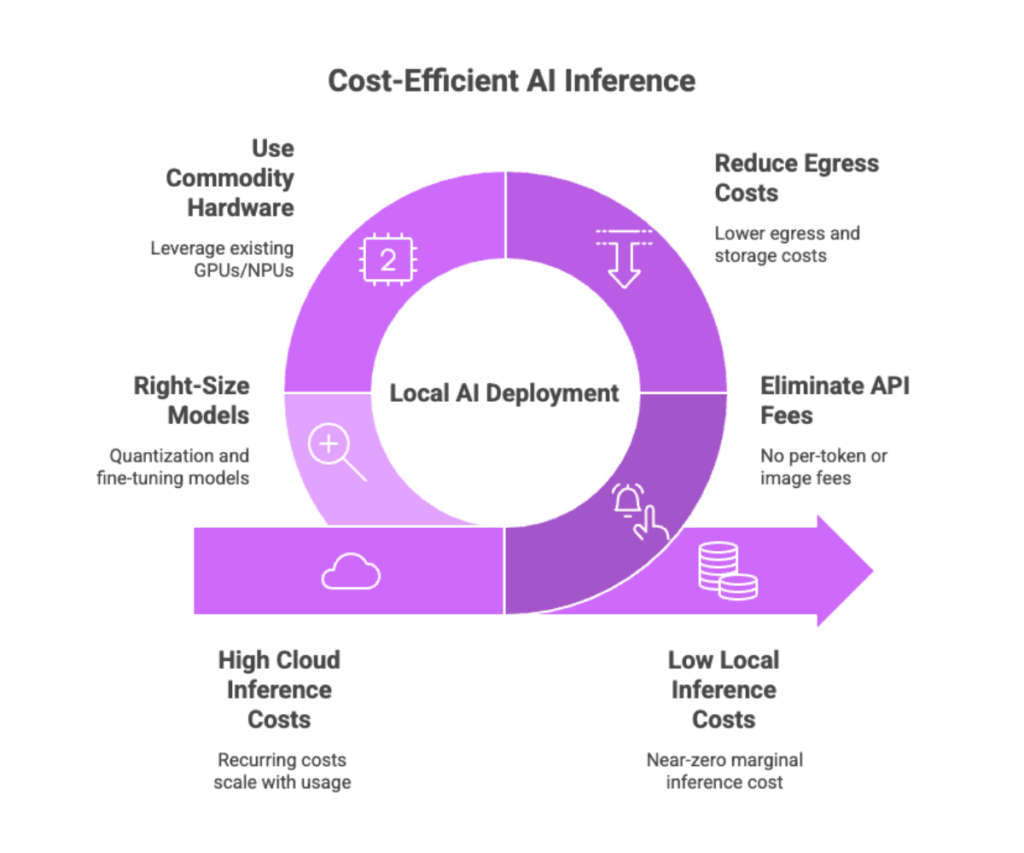

☁️ 雲端 LLM 的成本本質:持續租金

雲端成本通常來自:

- API token 用量

- GPU 推論時數

- VRAM 長時間占用

- 網路流量

特性是:

- 用越多,付越多

- 不用時才省

- 長期容易「不知不覺爆表」

📌 雲端是 OPEX(營運費)。

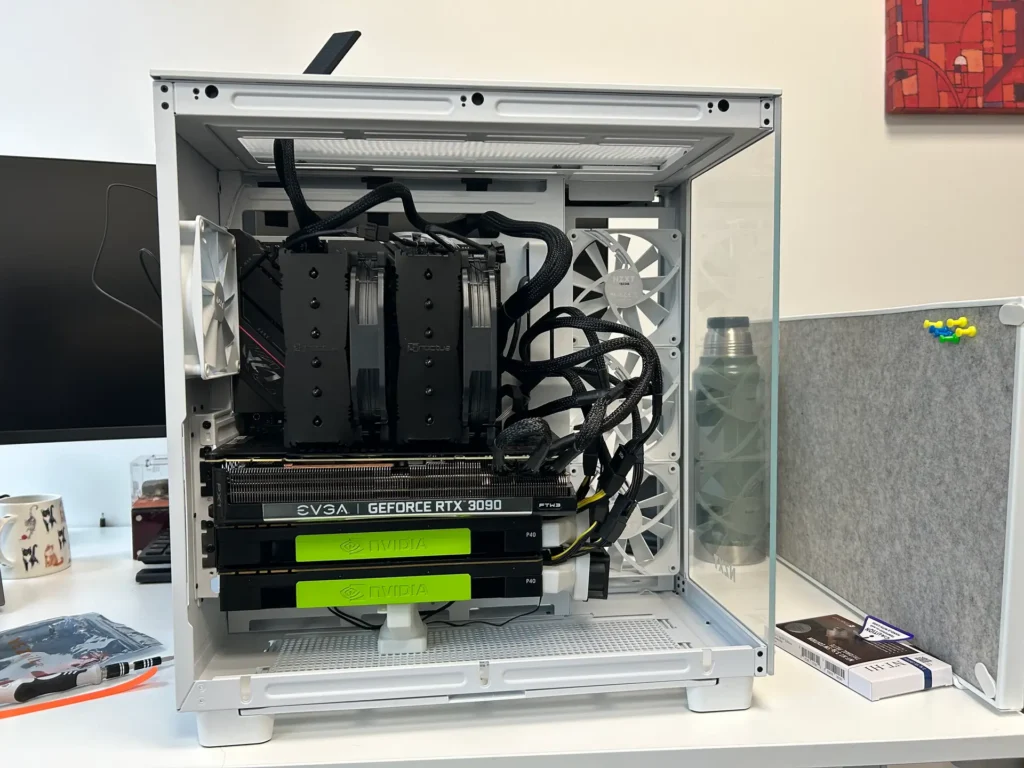

🖥️ 本地 LLM 的成本本質:一次性投資

本地成本通常是:

- GPU / 主機一次性採購

- 電力

- 少量維運時間

特性是:

- 前期貴

- 後期邊際成本接近 0

- 用越久,單次成本越低

📌 本地是 CAPEX(資本支出)。

關鍵問題不是「貴不貴」,而是「用多久」

一個非常重要的觀念

本地 LLM 不是用來「省第一個月的錢」,

而是用來「省第二年以後的錢」。

什麼情況下,本地 LLM 開始贏過雲端?

以下是實務上最常見、也最關鍵的 5 個轉折點。

① 使用頻率「每天都在用」

如果你的 AI:

- 每天用

- 一天多次

- 多個部門在用

那雲端的:

- API 費

- GPU 小時計費

會變成 固定月費。

👉 這是本地開始佔優的第一個訊號。

② 推論是「常駐服務」,不是偶發任務

雲端很適合:

- 跑完就關的訓練

- 偶爾呼叫的 API

但如果你的 LLM:

- 24/7 常駐

- 等使用者來問

- 每次都要立即回應

那你其實是在 「長租 GPU」。

📌 長租 ≠ 彈性,通常 ≈ 昂貴。

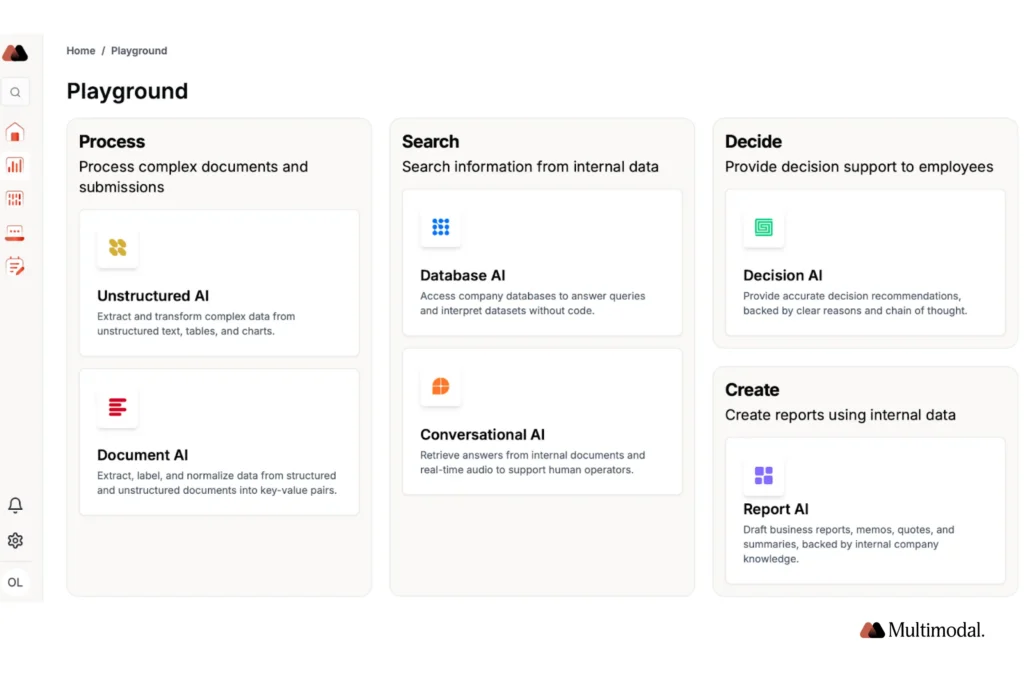

③ 資料是內部文件、不能外流

當你的 AI 用的是:

- 內部文件

- 合約、法務

- ERP、EIP、內部流程

即使雲端技術上可行,你仍然需要:

- 額外資安審查

- 合約與風險控管

- 擔心資料留存

👉 本地 LLM 在這裡不只省錢,還省心。

④ 使用人數穩定,而不是爆量

本地 LLM 非常適合:

- 使用人數可預期

- 10 人、20 人、50 人

- 不是突然衝到幾千人

📌 因為:

- 雲端是「用量越大越貴」

- 本地是「人數增加,邊際成本很低」

⑤ 已經知道「這會是長期工具」

如果你的判斷是:

- 這不是 PoC

- 這會用 2–3 年

- 會成為日常工具

👉 那你其實已經在做 長期投資,

而不是臨時消費。

什麼情況下,雲端還是比較省?

請老實對照下面這些情況 👇

☁️ 雲端比較划算,如果你是:

- 偶爾用、低頻使用

- PoC / Demo 階段

- 使用量高度不確定

- 需要快速上線

- 不想管任何硬體

📌 雲端的優勢是「不確定性低風險」。

一個超實用的判斷表

| 問題 | 偏向雲端 | 偏向本地 |

|---|---|---|

| 使用頻率 | 偶爾 | 每天 |

| 推論型態 | 偶發 | 常駐 |

| 使用人數 | 不確定 | 穩定 |

| 資料性質 | 公開 / 不敏感 | 內部 / 敏感 |

| 成本型態 | 希望小額月費 | 可接受一次性投資 |

| 使用年期 | < 1 年 | ≥ 2 年 |

👉 右邊勾越多,本地越合理。

一句話請直接記住

雲端是為「不確定性」付費,

本地是為「確定性」投資。

最後結論

本地 LLM 並不是一開始就最便宜,

但在「高頻、長期、內部使用」的情境下,

幾乎一定會比雲端便宜。

真正該問的不是:

- 「本地是不是比較省?」

而是:

- 「我們是不是已經用到,該轉成本地的那個階段?」