在企業導入 AI 時,幾乎一定會遇到這個選擇題:

「我們是要用 RAG,還是要做 Fine-tuning?」

這個問題之所以常被問錯,是因為很多人以為它們是互相替代的方案。

事實上——

👉 RAG 和 Fine-tuning 解決的是「完全不同的問題」。

這篇文章會用白話+架構角度,幫你一次搞清楚。

先給結論(一句話版)

RAG 解決的是「模型不知道資料在哪裡」,

Fine-tuning 解決的是「模型不知道該怎麼做事」。

如果你把問題分清楚,答案通常會自己出現。

先釐清兩者在做什麼(非常重要)

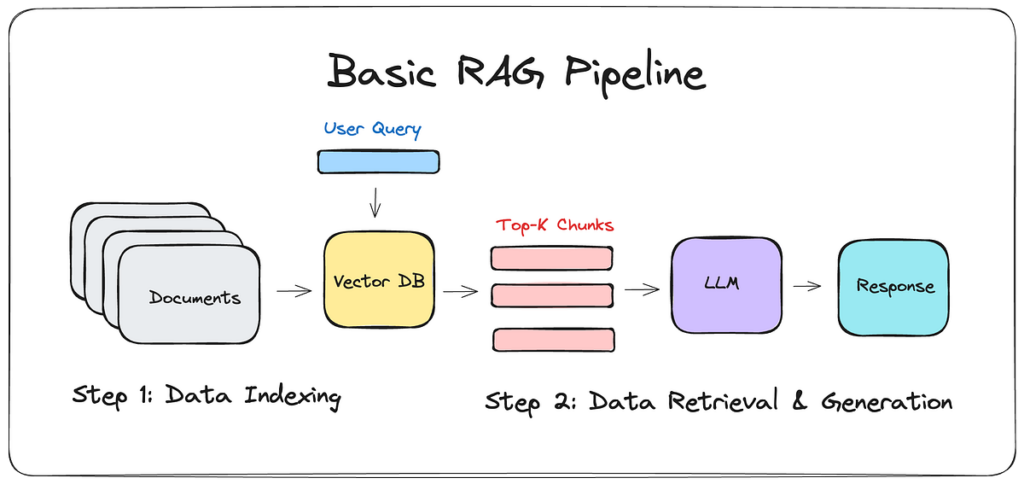

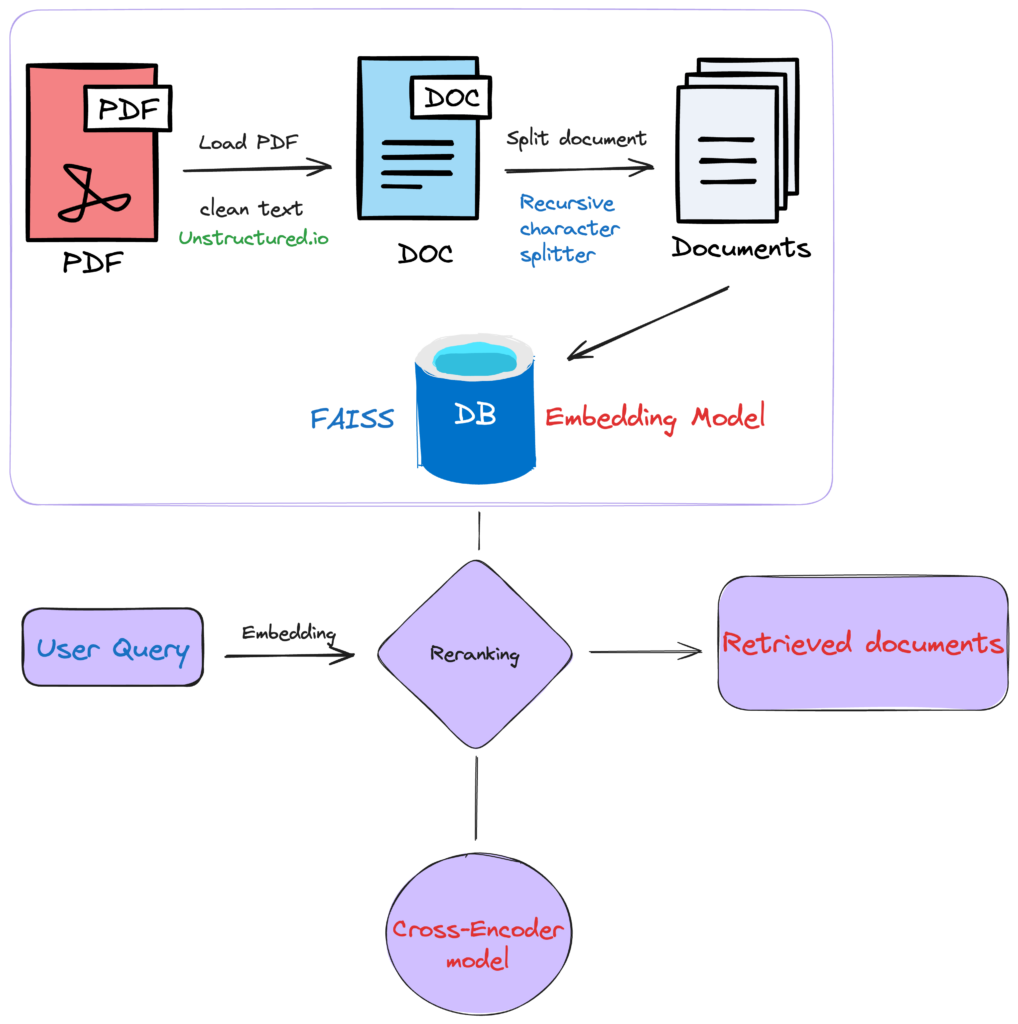

🔎 RAG(Retrieval-Augmented Generation)

- 不改模型

- 不動權重

- 即時取資料,塞進 context

- 只影響「這一次回答」

👉 本質是:即時資料注入(Inference 行為)

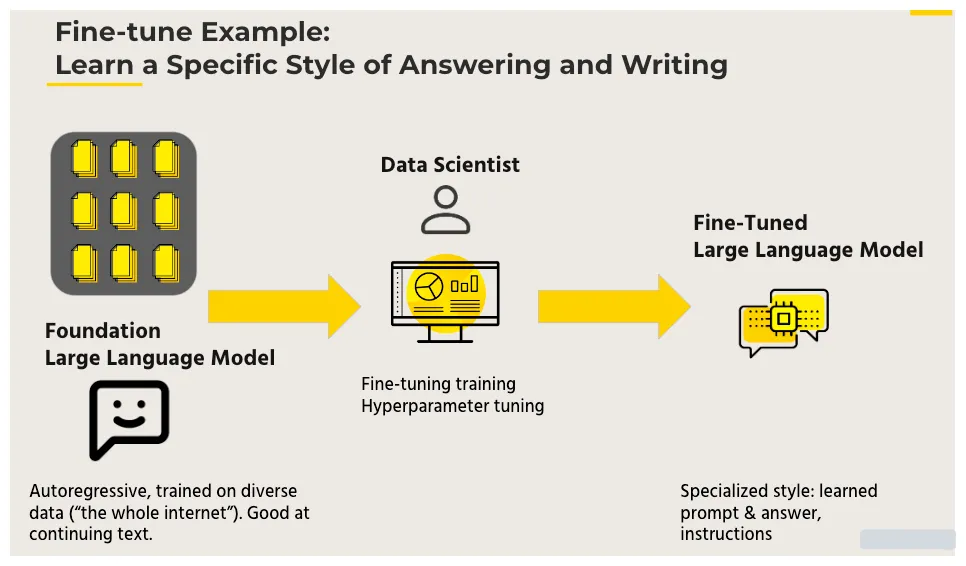

🧠 Fine-tuning

- 會改模型權重

- 需要訓練

- 資料被「學進模型」

- 影響所有未來回答

👉 本質是:模型能力調整(Training 行為)

用一個最直覺的比喻

RAG 就像「考試時可以翻資料」

Fine-tuning 就像「把解題方法背起來」

- 資料常變 → 翻資料比較合理

- 方法固定 → 背起來比較有效

什麼情況「一定要用 RAG」?

適合 RAG 的典型場景

- 公司內部文件

- SOP / 規章 / 合約

- ERP / EIP / 流程說明

- 法規、政策、公告

- 資料會變、會刪、會更新

📌 為什麼?

- 不想每改一次文件就重訓

- 需要即時生效

- 需要可回收、可控

👉 這些資料「不該被學進模型」。

什麼情況「適合 Fine-tuning」?

適合 Fine-tuning 的典型場景

- 回答風格(語氣、格式)

- 固定流程(填表、摘要、分類)

- 特定任務能力(抽取欄位、判斷)

- 專業語言用法(醫療、法務語境)

📌 這些特點是:

- 不常變

- 高度一致

- 屬於「能力」而非「資料」

👉 能力,才值得被訓練進模型。

把 RAG 拿去做 Fine-tuning,會發生什麼?

這裡直接說結果,避免你踩坑。

❌ 問題一:成本爆炸

- 文件一多,訓練成本直線上升

- 每次更新都要重來

❌ 問題二:資料過期、不可逆

- 舊資料學進去,刪不掉

- 合規、法務風險極高

❌ 問題三:效果其實不一定更好

- 文件品質不齊

- 噪音被學進模型

- Debug 非常困難

👉 這正是 RAG 被發明出來的原因。

那只用 RAG、不 Fine-tune 行不行?

可以,而且很多時候就夠了。

但如果你發現:

- 模型常常「聽不懂你要它幹嘛」

- 回答格式不穩

- 邏輯步驟亂跑

👉 那問題不是資料,而是能力不足。

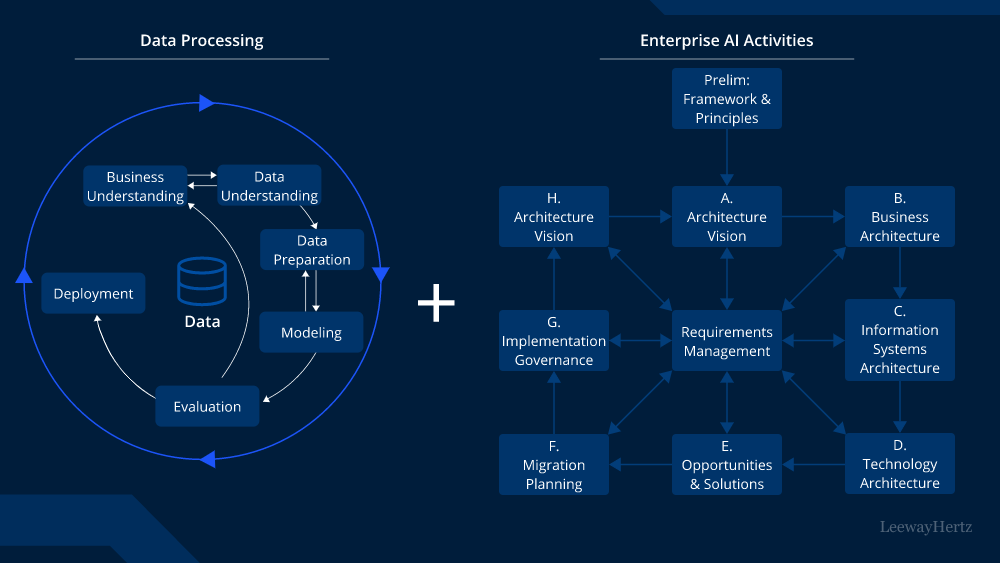

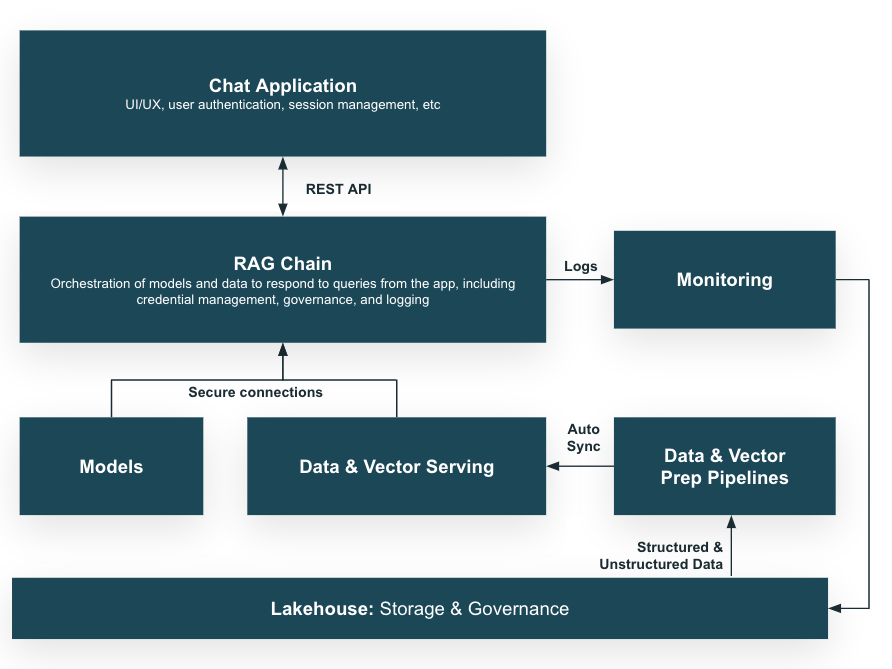

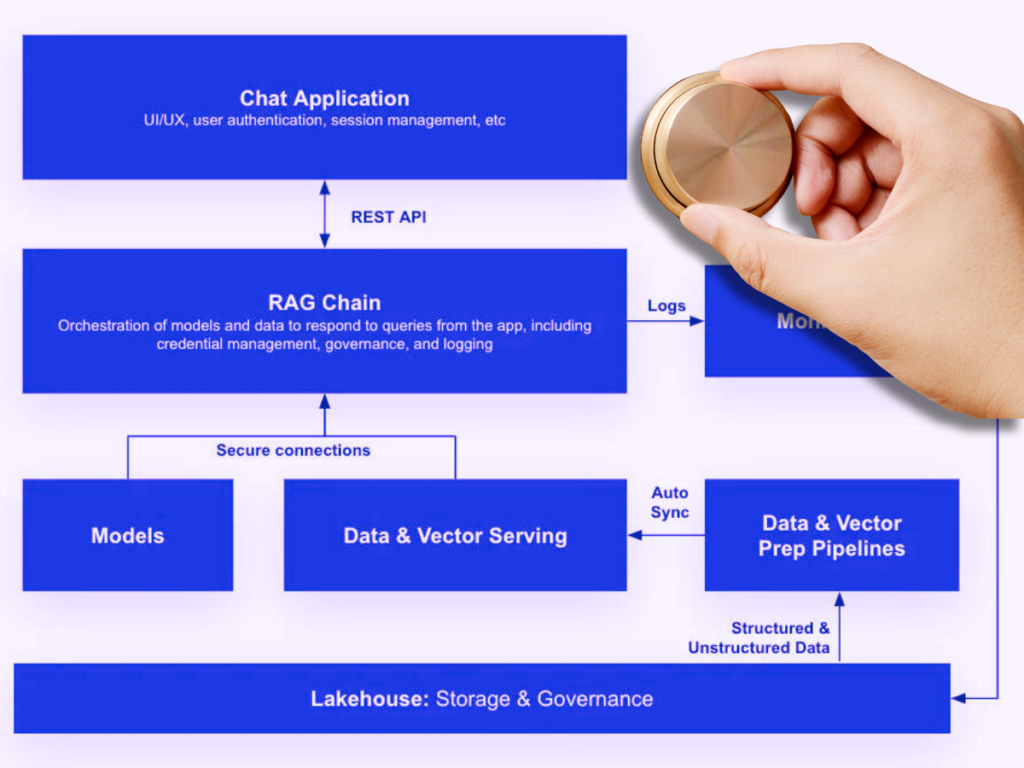

最實務、也最推薦的做法:兩個一起用

正確分工應該是:

- Fine-tuning:

- 教模型「怎麼回答」

- 教格式、流程、風格、邏輯

- RAG:

- 提供「現在要用的資料」

- 文件、知識、事實來源

👉 能力靠訓練,知識靠檢索。

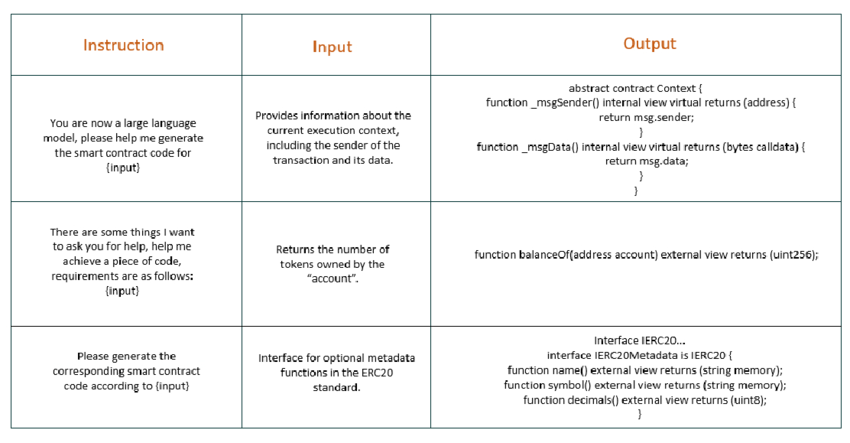

一張表幫你快速選

| 問題類型 | RAG | Fine-tuning |

|---|---|---|

| 資料常變 | ✅ | ❌ |

| 需要即時更新 | ✅ | ❌ |

| 回答格式不穩 | ❌ | ✅ |

| 特定任務能力 | ❌ | ✅ |

| 合規 / 可回收 | ✅ | ❌ |

| 成本可控 | ✅ | ❌ |

一句話請直接記住(超重要)

不要用 Fine-tuning 解決資料問題,

也不要用 RAG 解決能力問題。

最後結論

RAG 和 Fine-tuning 不是二選一,

而是各司其職。

- 資料問題 → RAG

- 能力問題 → Fine-tuning

- 企業實務 → 兩者搭配

只要你照這個原則走,

幾乎不會走錯架構。