在規劃 AI 架構時,很多人會直接問:

「我們要用雲端,還是本地部署?」

但這個問題,其實少問了一半。

真正該先問的是:

👉 你現在的 AI 工作,主要是「訓練」還是「推論」?

因為 訓練與推論,對「雲端 vs 本地」的答案,往往完全相反。

先給結論(一句話版)

AI 架構選擇的第一層分水嶺是「訓練 vs 推論」,

第二層才是「雲端 vs 本地」。

搞錯順序,幾乎一定會選錯架構。

先把兩件事說清楚

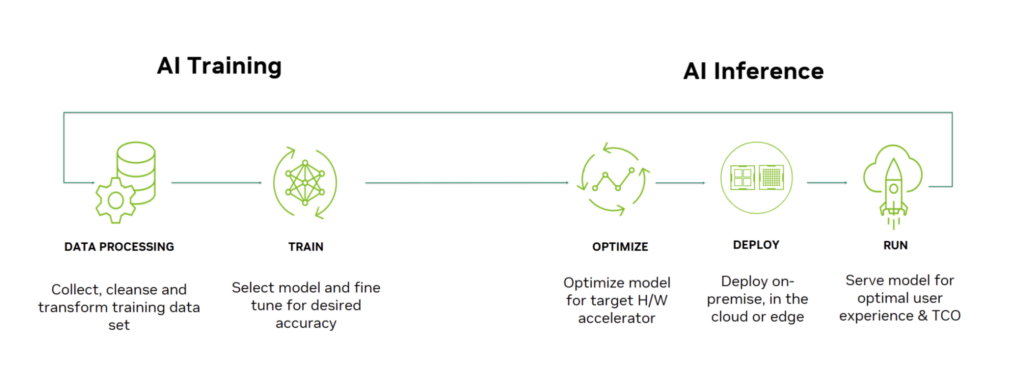

🧠 AI 訓練(Training)

- 目的:讓模型學習、調整權重

- 特性:

- 極高算力需求

- 短期密集運算

- 任務完成即可關機

- 成本型態:

- 算力導向

- 用多少付多少

💬 AI 推論(Inference)

- 目的:實際使用模型

- 特性:

- 長時間常駐

- 對延遲與穩定度敏感

- 記憶體比算力重要

- 成本型態:

- 營運導向

- 24/7 持續成本

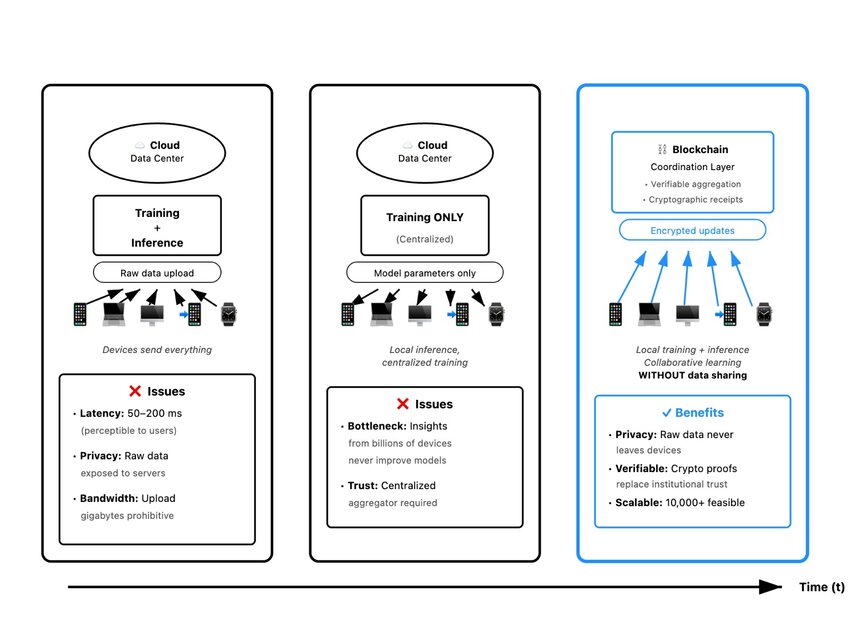

為什麼「訓練」通常適合雲端?

訓練的本質需求

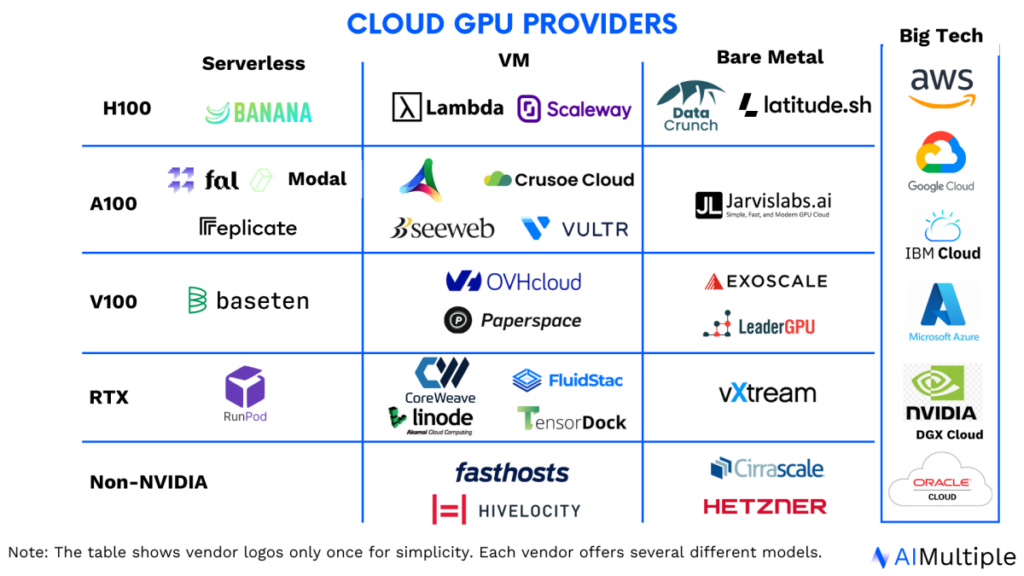

- 非常強的 GPU

- 多卡 / 多節點擴展

- 高功耗、短時間使用

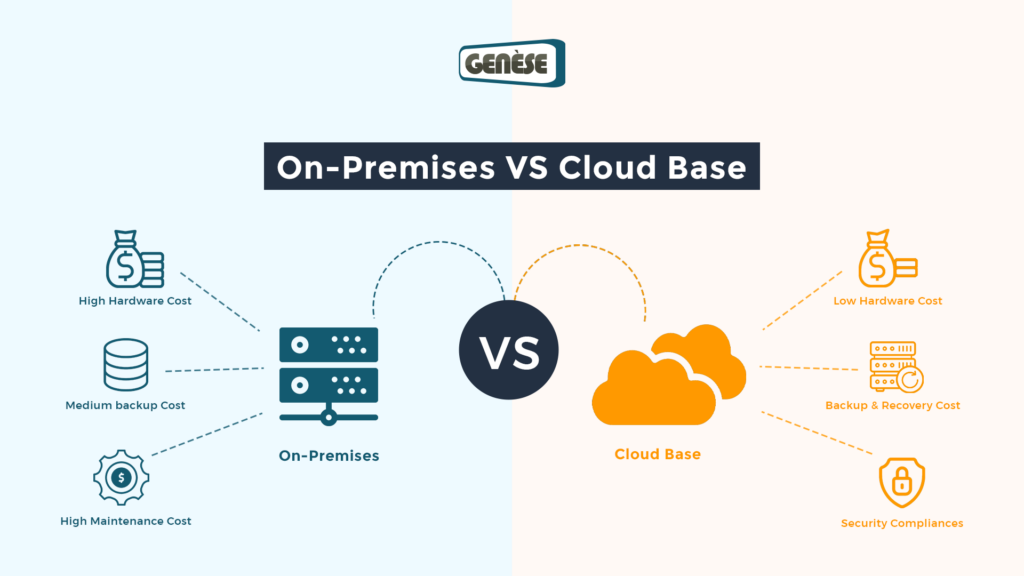

雲端的優勢

- 需要時才租用頂級 GPU

- 不用自己處理散熱、電力、機房

- 任務完成即可釋放資源

📌 對訓練來說,雲端是「彈性算力池」。

什麼情況下「訓練 + 雲端」最合理?

- 偶爾才訓練

- 模型尺寸不斷變化

- 需要最新 GPU

- 不想承擔硬體折舊

👉 大多數公司,訓練放雲端是最省心的選擇。

為什麼「推論」常常適合本地?

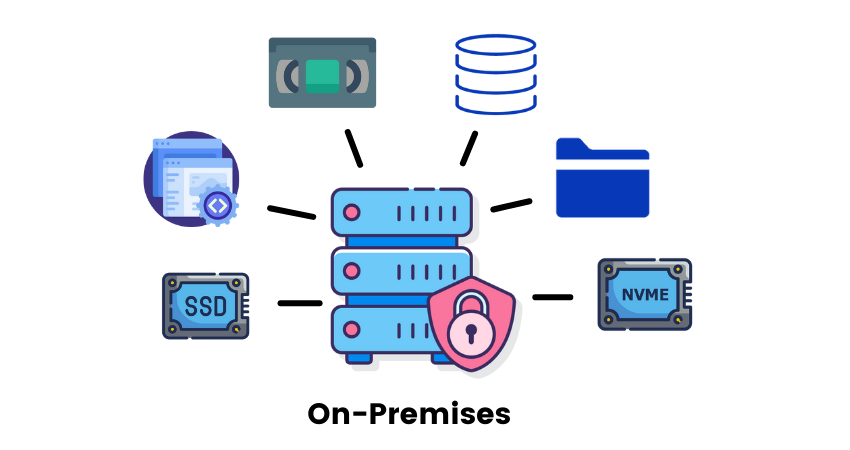

推論的本質需求

- 模型常駐記憶體

- 低延遲、穩定

- 長時間運行

- 成本可預期

本地部署的優勢

- 一次性硬體投資

- 沒有長期雲端租用費

- 延遲最低

- 資料不出內網

📌 對推論來說,本地是「長期服務平台」。

什麼情況下「推論 + 本地」最合理?

- 使用頻率高(每天都用)

- 對延遲敏感

- 資料涉及內部文件、隱私

- 希望成本可控

👉 本地推論常常比雲端便宜,也更穩定。

那「推論用雲端」行不行?

可以,但要想清楚代價。

雲端推論的優點

- 快速上線

- 易於擴展

- 不用管硬體

雲端推論的隱性成本

- 24/7 GPU 租用費

- VRAM 永遠在算錢

- 網路延遲與不穩定

- 長期成本容易失控

📌 推論一旦變成日常服務,雲端成本會快速放大。

一張表看懂「訓練 / 推論 × 雲端 / 本地」

| 工作類型 | 雲端 | 本地 |

|---|---|---|

| 訓練 | ✅ 非常適合 | ❌ 成本高、彈性低 |

| 推論(高頻) | ⚠️ 成本易失控 | ✅ 穩定、可控 |

| 推論(低頻) | ✅ 快速方便 | ⚠️ 投資可能過高 |

| 高隱私資料 | ⚠️ 需審慎 | ✅ 最安全 |

| 快速實驗 | ✅ | ⚠️ |

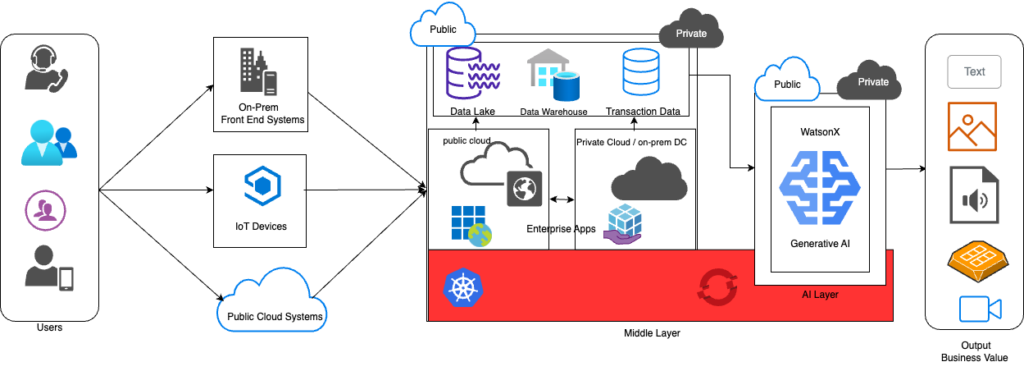

最常見、也最合理的做法:混合架構

很多成熟團隊實際採用的是:

訓練在雲端,推論在本地

好處包括:

- 訓練彈性最大化

- 推論成本最小化

- 架構清楚、責任分離

- 容易控管風險

📌 這是目前最主流、也最實務的選擇。

一個簡單的判斷流程(實用)

請照順序問自己:

- 我現在是在訓練,還是在推論?

- 這個工作是偶爾,還是每天?

- 我在意延遲、資料安全、還是彈性?

- 這筆成本是一次性,還是長期?

👉 答案通常會自己浮現。

一句話請直接記住

訓練追求的是「彈性算力」,

推論追求的是「長期穩定」。

最後結論

沒有「一定要雲端」或「一定要本地」,

只有「這個工作適合放在哪裡」。

- 訓練 → 多半雲端最合理

- 推論 → 多半本地最划算

- 成熟架構 → 混合最好