只要你接觸過 AI 或深度學習,一定聽過這句話:

「AI 訓練一定要用 GPU,沒有 GPU 根本跑不動。」

但為什麼?

CPU 不是也能算嗎?

CUDA 到底扮演什麼角色?

這篇文章,我們不用數學、不寫公式,只從「AI 在算什麼」開始講清楚原因。

先說結論(一句話版)

因為 AI 訓練的本質,是「超大量、可平行的矩陣運算」,

而 GPU + CUDA 正是為這種工作而生。

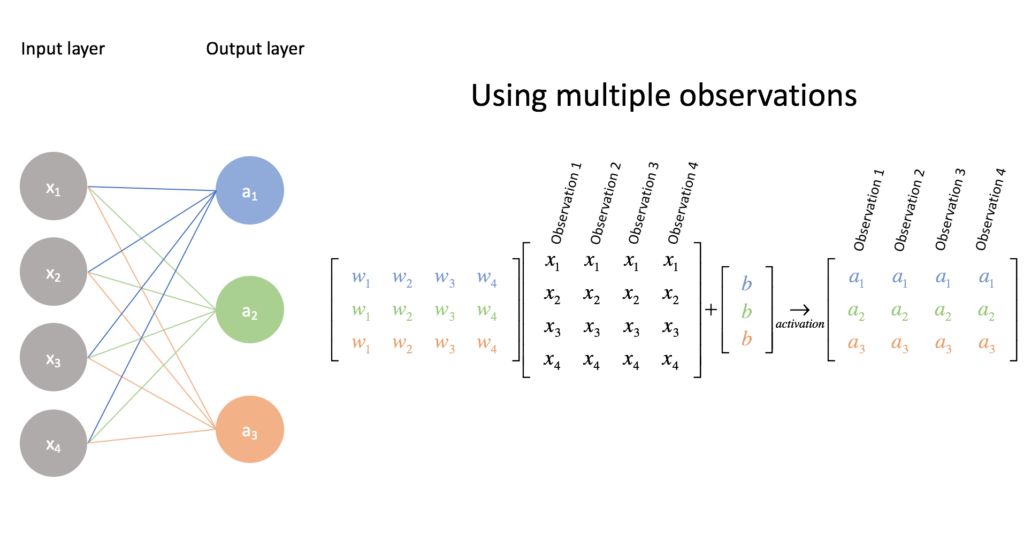

AI 訓練到底在「算什麼」?

很多人以為 AI 在做「思考」,其實不然。

AI 訓練在做的事,本質只有三件:

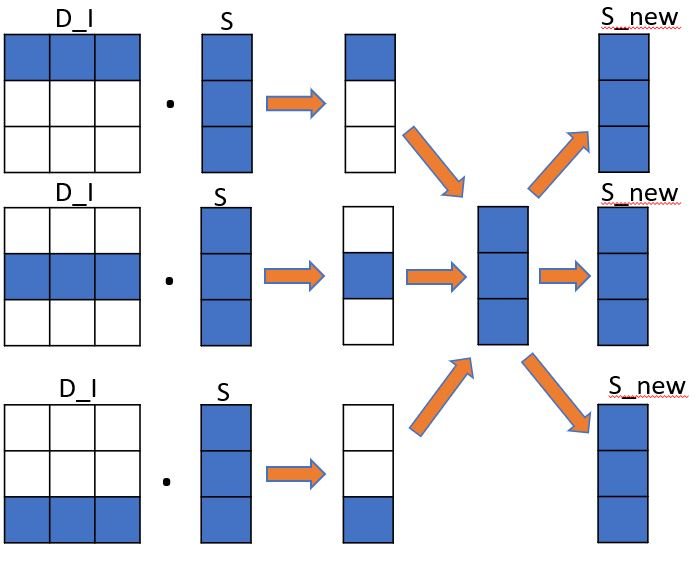

- 大量矩陣乘法

- 大量加法

- 同樣的計算,重複幾百萬到幾十億次

例如一個神經網路:

- 每一層 = 一個大矩陣

- 每一次訓練 =

- Forward(往前算)

- Backward(反向更新權重)

📌 這不是智慧問題,而是體力活

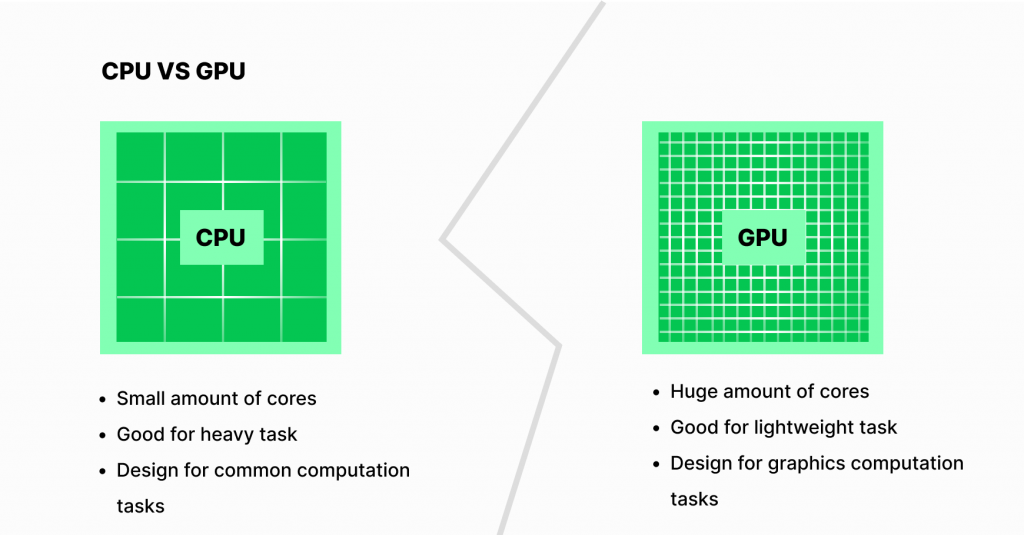

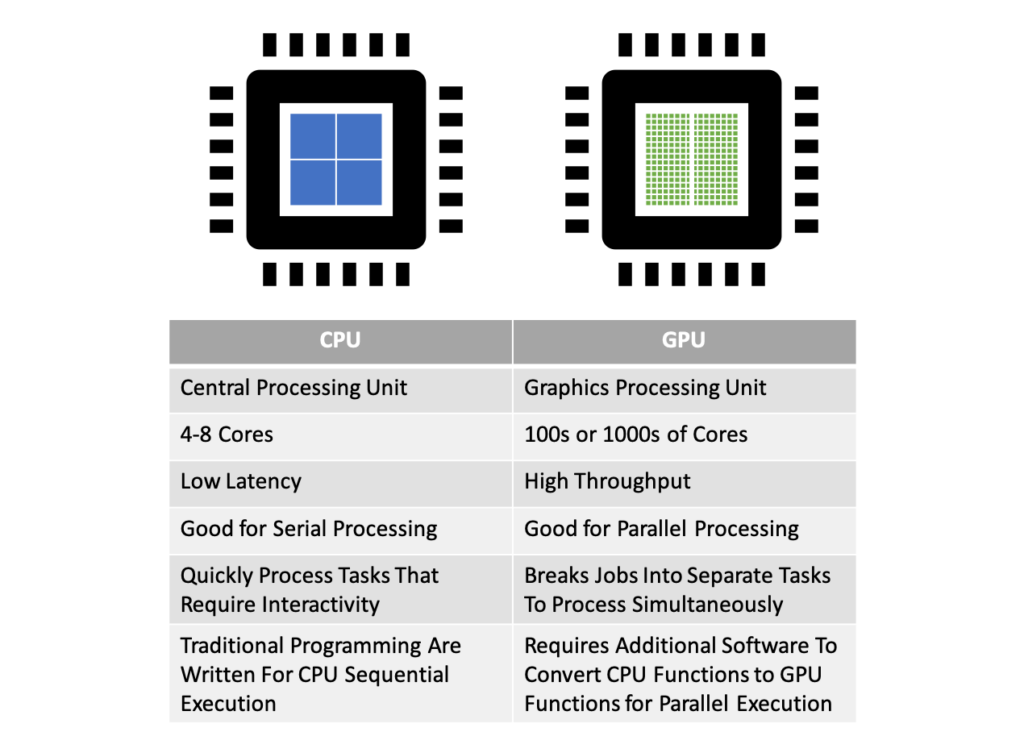

為什麼 CPU 不適合 AI 訓練?

CPU 的強項

- 邏輯判斷(if / else)

- 程式流程控制

- 系統管理、排程

但 AI 訓練的需求是:

- 同一個公式

- 對「超大量資料」

- 同時重複計算

👉 CPU 就像 一個很聰明、但人很少的主管

👉 AI 訓練需要的是 上萬個工人同時搬磚

GPU 為什麼特別適合 AI?

GPU 的設計初衷

GPU 原本是為了「畫圖」而生的:

- 一張畫面 = 上百萬像素

- 每個像素都做「幾乎一樣的計算」

📌 這和 AI 訓練 完全一樣

GPU 的優勢(白話版)

| GPU 特性 | 為何對 AI 有利 |

|---|---|

| 上千~上萬核心 | 同時算很多資料 |

| SIMT 架構 | 所有核心跑同一套公式 |

| 高頻寬記憶體 | 快速餵資料給模型 |

| 專用矩陣單元 | 專門加速矩陣乘法 |

👉 AI 訓練 = GPU 的天職

那 CUDA 在這中間做什麼?

GPU 很強,但有一個問題:

要怎麼「正確指揮」這麼多核心?

答案就是:CUDA

CUDA 是 AI 訓練的「交通規則」

CUDA 是由 NVIDIA 設計的一套:

- 平行運算模型

- 記憶體存取規則

- GPU 指揮方式

👉 CUDA 負責把 AI 訓練拆成:

- 幾百萬個一模一樣的小計算

- 分配給 GPU 同時執行

- 最後快速收回結果

沒有 CUDA,會發生什麼事?

情境一:只有 CPU

- 可以跑

- 慢到不可用

- 一個模型可能要訓練「幾個月」

情境二:有 GPU,但沒有 CUDA

- 硬體在

- 無法有效使用

- 核心大多在閒置

情境三:GPU + CUDA

- 核心全開

- 記憶體路徑最佳化

- 訓練時間從「月」變「天 / 小時」

為什麼大語言模型一定要 GPU / CUDA?

以 LLM(大型語言模型)為例:

- 參數量:

- 幾十億

- 幾百億

- 甚至上千億

- 每一次訓練步驟:

- 都是矩陣 × 矩陣

📌 沒有 GPU,參數多到算不完

📌 沒有 CUDA,GPU 算不快

這也是為什麼:

- PyTorch

- TensorFlow

- 大多數 AI Framework

👉 都是 CUDA-first 設計

那 AMD / Apple GPU 呢?

這不是說「只有 CUDA 能跑 AI」,而是:

- CUDA 成熟

- 生態完整

- 工具、文件、社群齊全

其他平台:

- 可以跑

- 但成本高、限制多、效能不穩

👉 在「訓練階段」,CUDA 仍然是主流選擇

總結:為什麼 AI 訓練一定要 GPU / CUDA?

因為 AI 訓練不是思考,而是超大量、可平行的數學運算。

- CPU:負責思考與控制

- GPU:負責體力活

- CUDA:讓 GPU 全力輸出、不浪費效能

一句話帶走

AI 訓練一定要用 GPU / CUDA,

不是因為潮流,而是因為「只有這套方法算得完」。