很多人會有一個直覺疑問:

「AMD 也有很強的 GPU,

為什麼有些 AI / 深度學習程式卻『跑不動 CUDA』?」

甚至會聽到這種說法:

- 「不是 GPU 嗎?怎麼不能跑?」

- 「是不是 NVIDIA 在鎖生態?」

- 「那買 AMD GPU 不就很吃虧?」

這篇文章,我們不站品牌立場,只從技術與生態角度,把原因一次講清楚。

先說結論(重點版)

CUDA 是 NVIDIA 專屬的平行運算平台,

AMD GPU 本來就「不支援 CUDA」。

這不是效能問題,也不是硬體強弱問題,

而是 「軟體平台與生態系選擇」的結果。

CUDA 是什麼?為什麼會「綁」GPU?

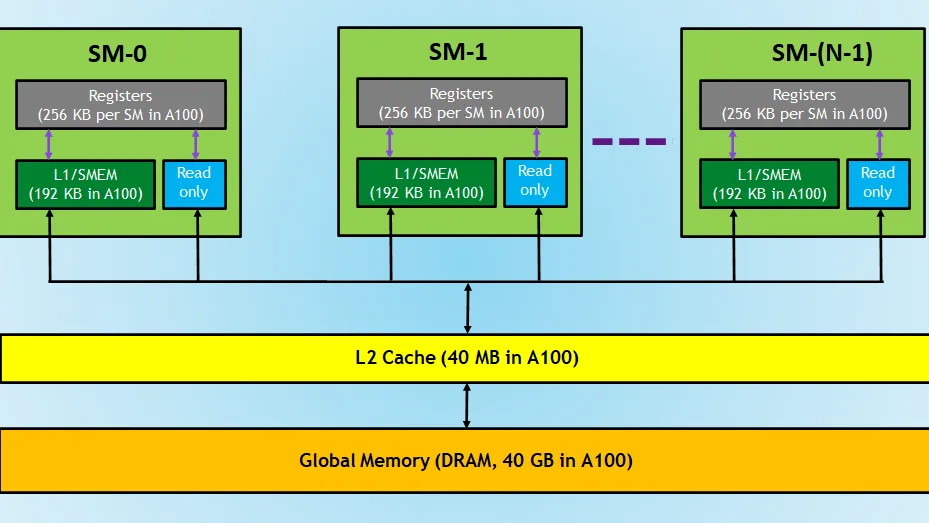

CUDA 是由 NVIDIA 開發的一套:

- GPU 平行運算模型

- 記憶體管理規則

- 編譯器、函式庫、工具鏈

📌 關鍵一句話:

CUDA 從設計一開始,就是「只給 NVIDIA GPU 用」的。

就像:

- DirectX 是微軟的

- Metal 是 Apple 的

👉 CUDA 是 NVIDIA 的「專屬語言 + 平台」

AMD GPU 為什麼「不能跑 CUDA」?

原因一:CUDA 不是通用標準

CUDA 不是像:

- C

- Python

- OpenCL

那樣的「跨平台標準」。

而是:

- 專屬 API

- 專屬編譯器(nvcc)

- 專屬驅動堆疊

👉 AMD GPU 沒有 CUDA runtime,也無法編譯 CUDA 程式

原因二:AI Framework 預設就是 CUDA-first

目前主流 AI Framework,例如:

- PyTorch

- TensorFlow

- JAX

👉 預設第一優先支援 CUDA

這代表:

- 官方文件以 CUDA 為主

- 範例、教學、最佳化都先給 CUDA

- 新功能通常先在 CUDA 上線

AMD GPU 不是不能用,而是:

常常「晚一步」或「少一些功能」

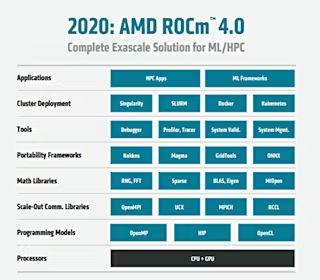

AMD 的解法是什麼?ROCm

AMD 並不是沒有回應。

他們推出了 ROCm(Radeon Open Compute):

- AMD 的 GPU 計算平台

- 功能角色 ≈ CUDA

- 支援 PyTorch / TensorFlow(部分)

但問題來了…

為什麼 ROCm 還是常常「不好用」?

1️⃣ 硬體支援範圍有限

- 不是所有 AMD GPU 都支援 ROCm

- 消費級卡常被排除或支援不完整

2️⃣ 作業系統限制多

- Linux 支援最好

- Windows 支援有限

- 驅動版本綁很死

3️⃣ 生態系與工具不成熟

- CUDA 有十多年累積

- ROCm 還在追趕

- 文件、範例、社群資源相對少

4️⃣ 效能調校成本高

- 同一個模型

- CUDA:直接跑

- ROCm:要調、要試、要踩雷

👉 工程成本 = 隱性成本

那是不是 NVIDIA 在「鎖生態」?

這是個常見但複雜的問題。

比較客觀的說法是:

- NVIDIA 很早就押注 CUDA

- 長期投入工具、生態、開發者

- 建立了「事實上的標準」

📌 結果是:

不是 AMD 不努力,而是 CUDA 領先太久

那 AMD GPU 還值不值得買?

視「你要做什麼」而定

✅ 適合 AMD GPU 的情境

- 已確認 ROCm 支援的模型

- 有 Linux + 技術團隊

- 能接受較高調校成本

- 預算有限但算力需求大

❌ 不適合 AMD GPU 的情境

- AI 初學者

- 快速 PoC / 專案交付

- 商業產品、穩定優先

- LLM 訓練 / 多 GPU Scale

用一句話講清楚差別

AMD GPU 不是算不快,

而是「CUDA 不是為它設計的」。

總結

- CUDA 是 NVIDIA 專屬平台

- AMD GPU 原生就不能跑 CUDA

- AMD 用 ROCm 對應,但生態仍在追趕

- 對 AI 訓練而言,「生態成熟度」往往比「理論算力」更重要

最後一句話帶走

在 AI 世界,

GPU 是硬體戰,

CUDA / ROCm 是生態戰。

目前這場戰爭,CUDA 還是領先者。