在選 GPU 跑本地 AI(尤其是 LLM)時,很多人第一眼會看:

- CUDA 核心數

- FLOPS

- 型號等級(RTX / A 系列)

但實際用過本地 LLM 之後,幾乎所有人都會遇到同一個痛點:

「GPU 很快,但模型根本載不進去。」

這時你才會發現一件事:

👉 在本地 AI 場景,VRAM 往往比 GPU 核心數更重要。

先給結論(一句話版)

本地部署 AI 的第一道門檻是「能不能把模型完整放進顯示記憶體」,

而不是「算得有多快」。

本地 AI 在「吃」什麼資源?

不是只有算力,而是「空間」

對本地 AI(特別是 LLM)來說,GPU 主要負責兩件事:

- 放模型

- 做推論計算

📌 問題是:

如果模型放不進 VRAM,第 2 件事根本不會發生。

一個常見誤解:核心數 ≈ 能跑更大的模型 ❌

很多人會以為:

「核心數多 → GPU 強 → 可以跑更大的模型」

這在 訓練場景 有一定道理,

但在 本地推論場景,這個推論常常是錯的。

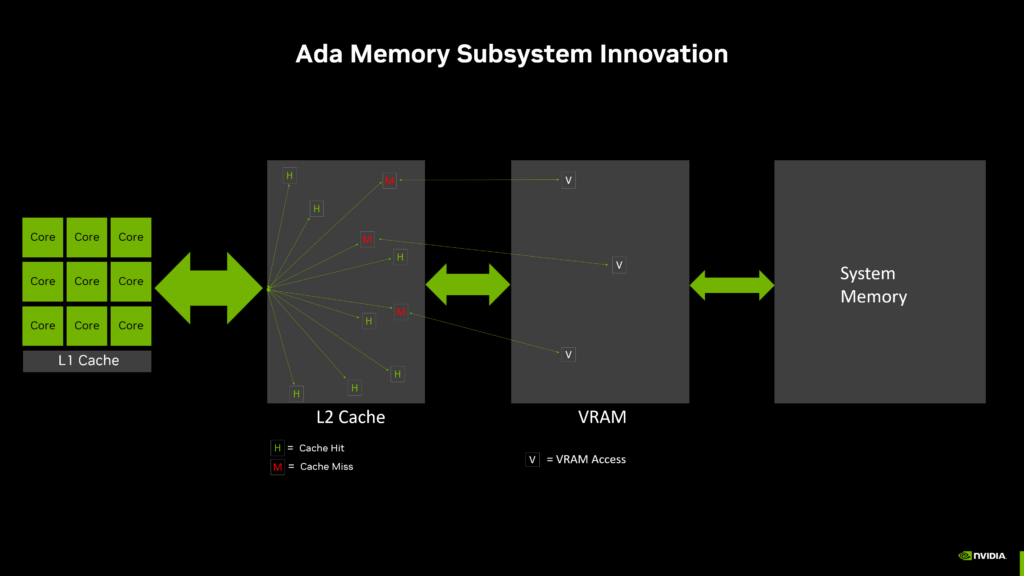

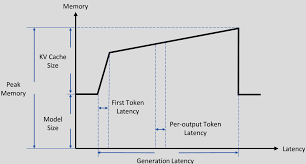

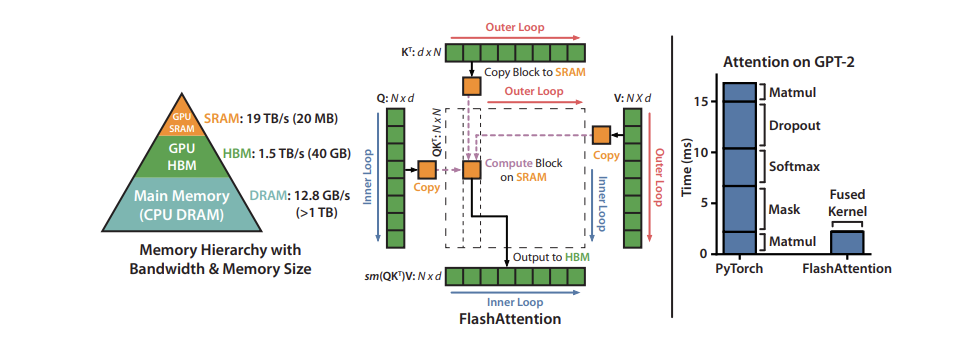

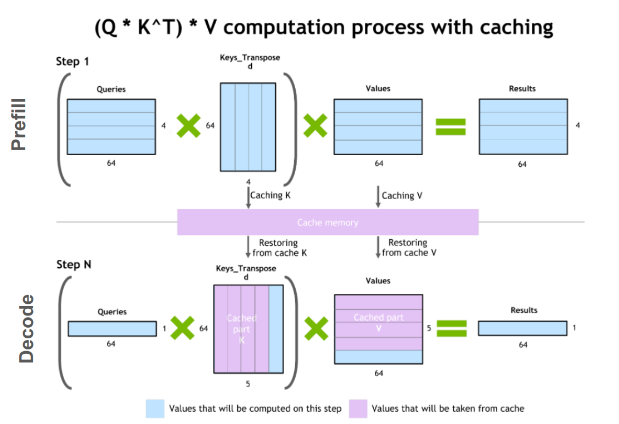

LLM 推論時,VRAM 裡要放什麼?

以一個 LLM 為例,VRAM 內至少要同時容納:

- 模型權重(weights)

- 中間計算結果(activations)

- KV Cache(token 歷史)

- Runtime / Framework buffer

👉 這些東西 加起來是「硬需求」,不能省。

為什麼 VRAM 不夠會「直接不能用」?

情境一:VRAM 不夠

- 模型無法載入

- 程式直接報錯(OOM)

- 或退回 CPU(速度崩潰)

情境二:VRAM 剛好

- 模型可載入

- 推論穩定

- 效能符合預期

📌 這是 能不能用 vs 用得好不好 的差別。

量化(Quantization)不是萬靈丹

你可能聽過:

- 8-bit

- 4-bit

- GGUF / GPTQ

量化確實可以降低 VRAM 需求,但:

- 精度會下降

- 某些模型不適合重度量化

- KV cache 仍然會吃記憶體

👉 量化是輔助,不是解藥。

一個很實際的對比例子

GPU A

- 10,000 核心

- 8GB VRAM

GPU B

- 5,000 核心

- 24GB VRAM

在本地 LLM 推論時:

👉 GPU B 幾乎一定比 GPU A 好用

因為:

- GPU A:模型可能根本載不進去

- GPU B:模型可完整放入、穩定推論

為什麼核心數在推論時「邊際效益很低」?

因為 LLM 推論的特性是:

- token 是 一個一個生 的

- 很難把單一請求完全平行化

- 核心常常在等資料,而不是在算

👉 多核心 ≠ 線性加速

VRAM 對本地 AI 的影響清單

| 項目 | VRAM 影響 |

|---|---|

| 能否載入模型 | 決定性 |

| 是否 OOM | 直接相關 |

| 可支援模型大小 | 決定性 |

| Context length | 高度相關 |

| 推論穩定性 | 非常重要 |

| 使用體驗 | 極大影響 |

本地 LLM 實用 VRAM 建議(推論)

以下是假設 單一使用者、本地推論 的經驗法則:

| VRAM | 適合模型 |

|---|---|

| 8GB | 非常小模型 / 強烈受限 |

| 12GB | 勉強 7B(高度量化) |

| 16GB | 7B 舒適 |

| 24GB | 7B / 8B 非常好、13B(量化) |

| 48GB+ | 13B+、大 context |

📌 記憶體越大,選擇自由度越高。

那什麼時候「核心數」才重要?

核心數在以下情況才是關鍵:

- AI 訓練

- 大 batch 推論

- 多使用者高併發

- 追求 tokens/sec 極限

👉 這些都不是「個人本地 AI」的典型場景。

一句話請直接記住

本地 AI 的第一關不是「算得快不快」,

而是「能不能放得下」。

最後結論

在本地部署 AI(尤其是 LLM)時,

VRAM 是地板,核心數只是天花板。

- VRAM 不夠 → 直接不能用

- VRAM 夠了 → 才開始談效能

如果你是:

- 本地 LLM

- 個人 AI 助手

- RAG / 文件問答

👉 優先選 VRAM,大於一切。