在導入 RAG(Retrieval-Augmented Generation)時,很多團隊會問:

「RAG 是不是該在訓練時就一起做?」

「要不要把文件直接餵進模型裡微調?」

如果你也有這些疑問,先給你一個非常重要的結論:

👉 RAG 幾乎一定要放在「推論層」,而不是訓練層。

這不是工具限制,而是 架構本質。

先給結論(一句話版)

RAG 的任務是「即時取資料、即時組 context」,

這件事只存在於「推論」,不屬於「訓練」。

先釐清一個常見誤解:RAG ≠ 讓模型記住資料

很多人以為 RAG 是:

「讓模型把公司文件『學進去』」

這其實是 錯的期待。

RAG 真正在做的是:

- 不改模型

- 不改權重

- 不重新訓練

👉 只是在「回答前,幫模型補資料」

換句話說:

RAG 是即時餵參考資料,不是長期記憶。

為什麼 RAG 天生屬於推論層?

因為 RAG 的三個核心動作,全部都是 推論行為。

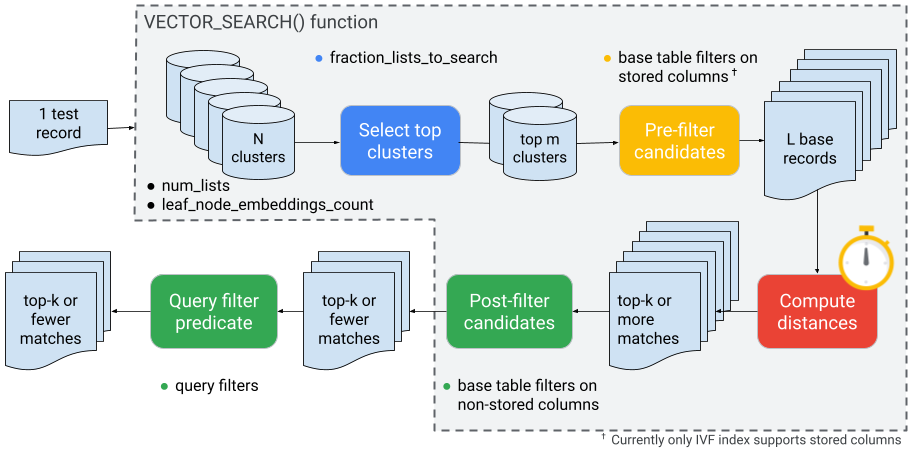

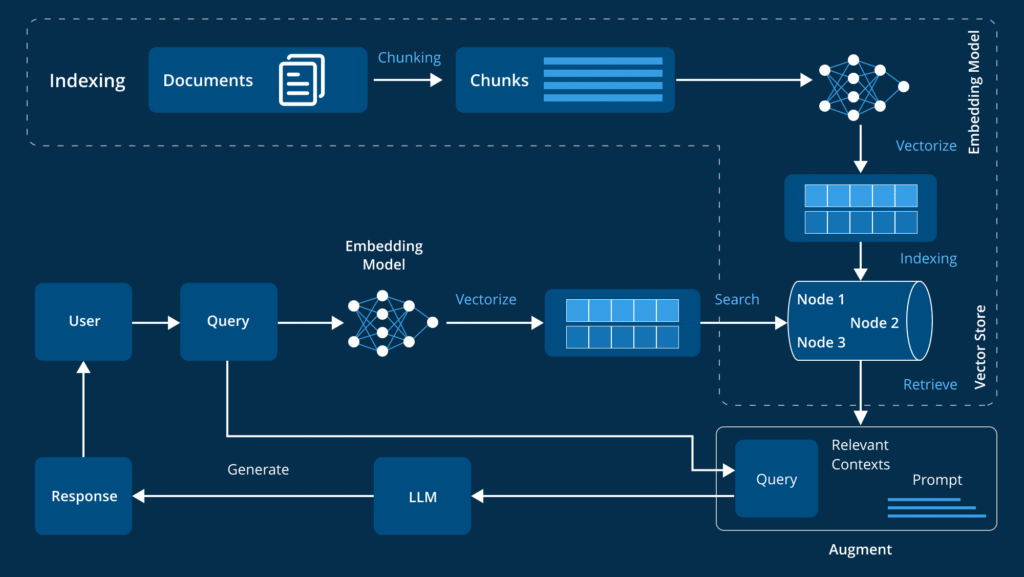

① RAG 是「即時查詢」,不是離線學習

RAG 的第一步是:

- 根據使用者問題

- 即時做向量搜尋

- 撈出「現在最相關」的文件

📌 關鍵是「現在」。

- 文件會變

- 問題會變

- 答案的參考依據會變

👉 這種動態行為,不可能放在訓練階段完成。

② RAG 的輸出只影響「這一次回答」

RAG 的文件:

- 只被塞進 prompt / context

- 用完就丟

- 不影響模型權重

📌 這代表:

- 沒有學習

- 沒有記憶累積

- 沒有模型變化

👉 這完全符合「推論」的定義。

③ RAG 要的是「最新資料」,不是「歷史資料」

如果你把資料丟進訓練或微調:

- 新文件 → 要重訓

- 文件修正 → 要重訓

- 文件刪除 → 幾乎不可逆

📌 對企業來說,這是災難。

👉 RAG 放在推論層,才能做到:

- 文件即時更新

- 不動模型

- 風險最低

把 RAG 放在訓練層,會發生什麼事?

這裡直接列出 實際會踩到的坑。

❌ 問題一:成本爆炸

- 訓練 / 微調要 GPU

- 每次資料變動都要重跑

- 成本隨文件量線性成長

👉 RAG 的價值正好是「避免重訓」。

❌ 問題二:資料過期、不可回收

- 舊資料學進模型

- 想刪卻刪不掉

- 法規、合約、政策變更風險極高

👉 推論層 RAG 可以立刻下架資料。

❌ 問題三:模型行為不可控

- 文件品質不一

- 訓練後偏差難以修正

- Debug 成本極高

👉 RAG 讓錯誤是「一次性的」,不是永久性的。

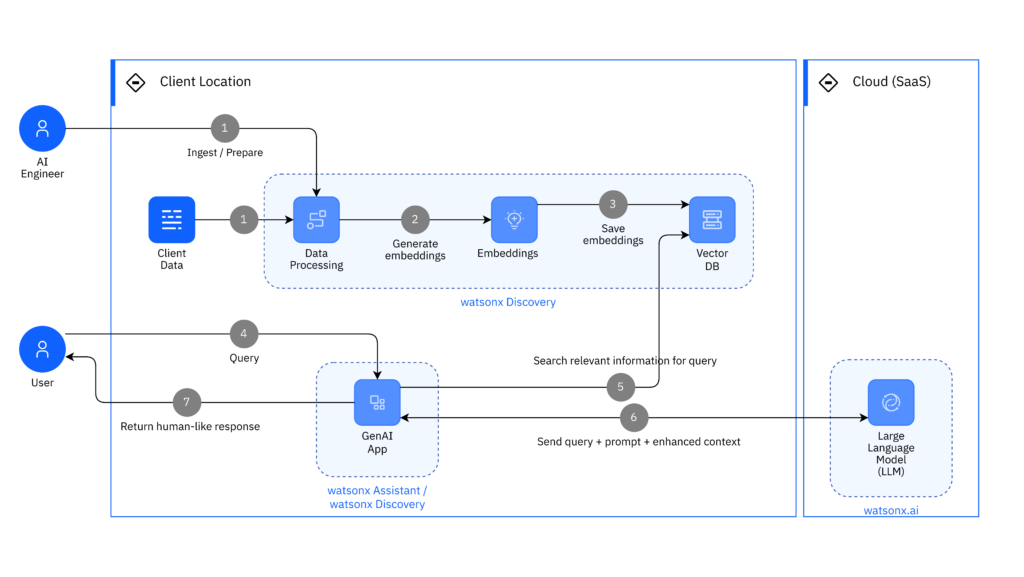

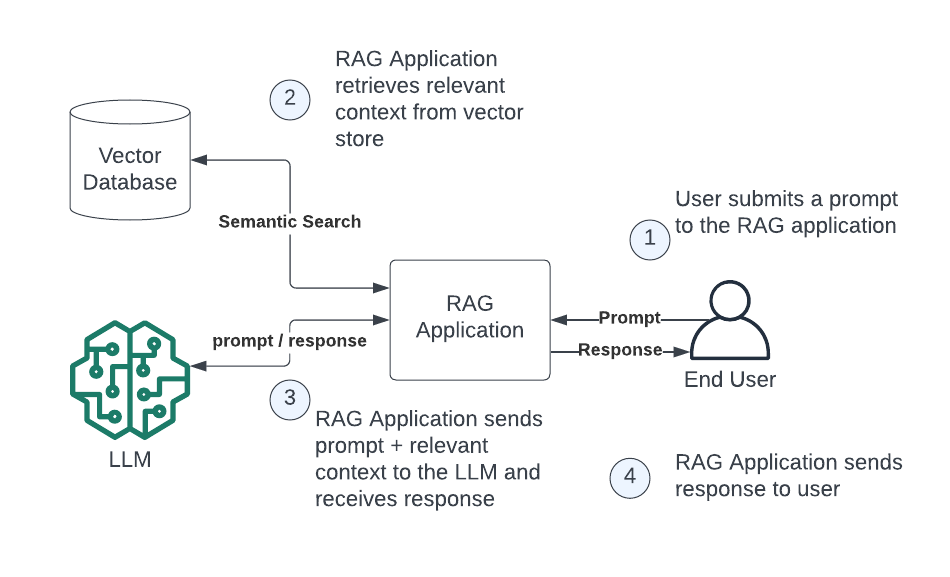

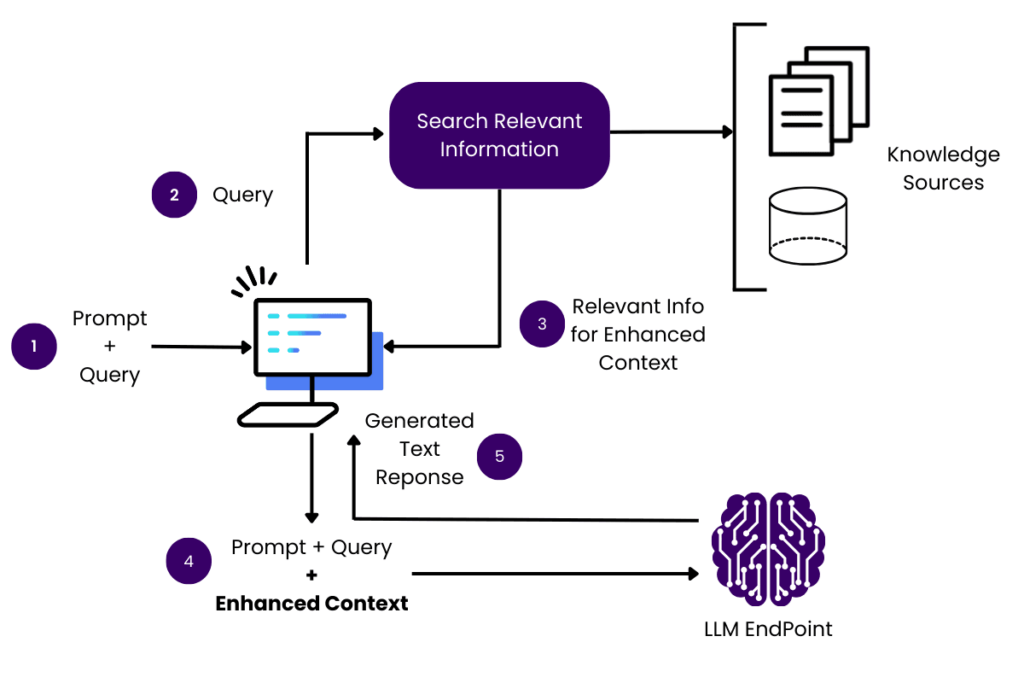

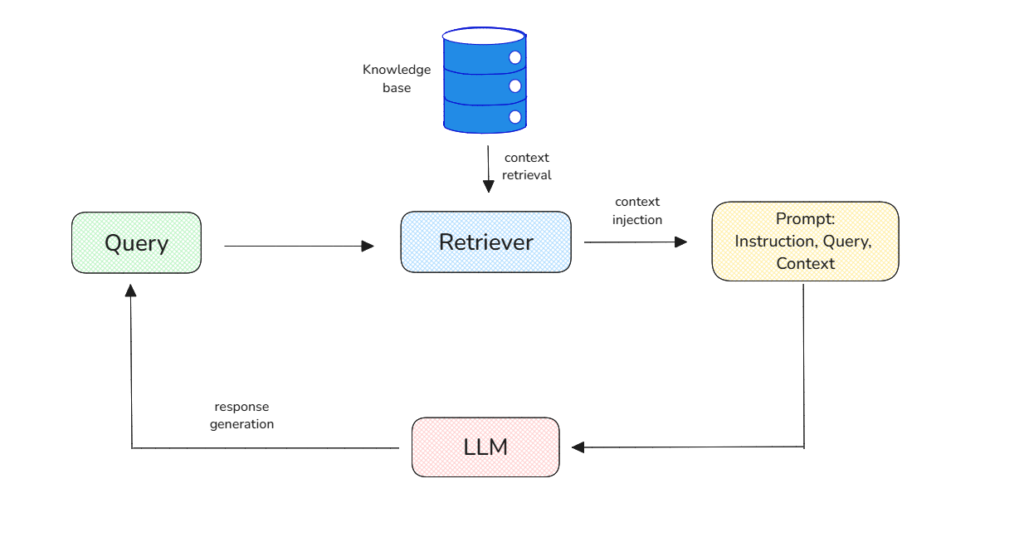

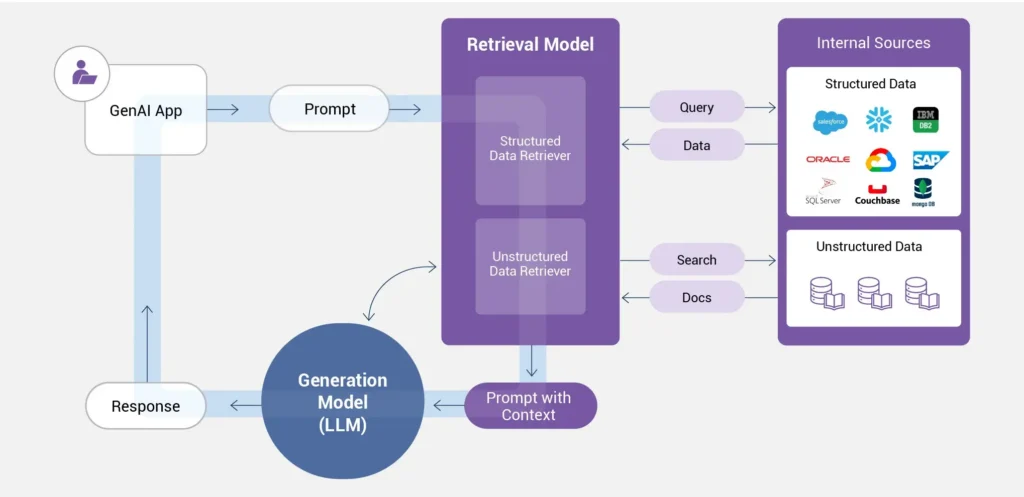

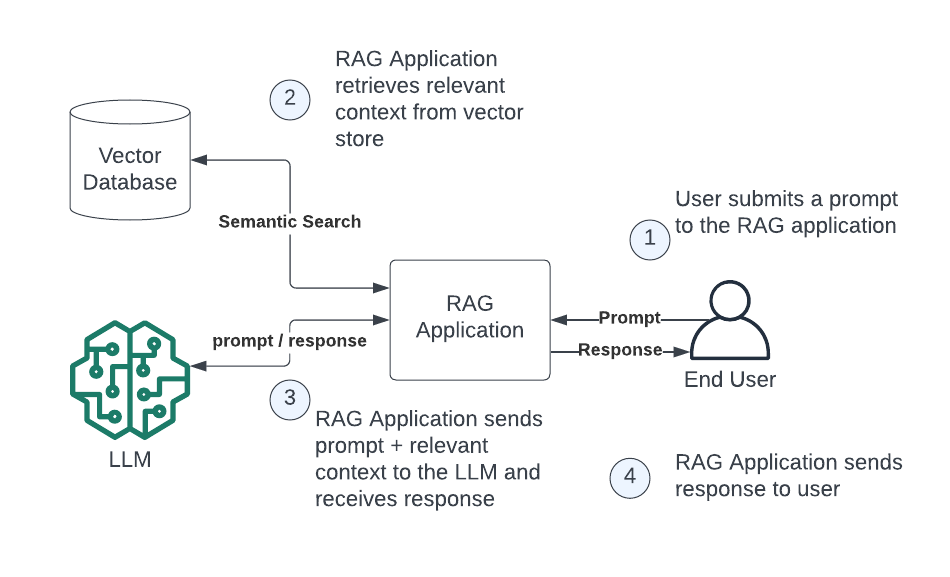

正確的 RAG 架構長什麼樣?

一個標準、可維運的 RAG 架構應該是:

- 使用者提問

- 向量化 Query

- 向量資料庫搜尋

- 挑選 Top-K 文件

- 組成 Prompt / Context

- 送進 LLM 推論

- 回傳答案

📌 整條流程只發生在推論階段。

那什麼東西才適合放在「訓練」?

請記住這個簡單區分:

適合訓練 / 微調的:

- 語言風格

- 回答格式

- 推理邏輯

- 任務能力(分類、摘要、抽取)

不適合訓練的:

- 公司文件內容

- 常變的政策

- 法規條文

- ERP / SOP / 合約細節

👉 知識用 RAG,能力用訓練。

一句話請直接記住(非常重要)

RAG 解決的是「資料在哪裡」,

訓練解決的是「模型會不會用」。

最後結論

RAG 一定要放在推論層,

因為它是「即時資料注入」,不是「模型學習」。

把 RAG 放錯層,會帶來:

- 成本失控

- 風險升高

- 維運困難

放對位置,反而會得到:

- 彈性

- 可控性

- 長期可擴展性